PingCAP TiDB全新一栈式实时HTAP数据库

立即咨询

TiDB 简介

TiDB 简介

高度兼容 MySQL 5.7

高度兼容 MySQL 5.7

TiDB 高度兼容 MySQL 5.7 协议、MySQL 5.7 常用的功能及语法。MySQL 5.7 生态中的系统工具 (PHPMyAdmin、Navicat、MySQL Workbench、mysqldump、Mydumper/Myloader)、客户端等均适用于 TiDB。

TiDB 价值

TiDB 价值

一种经典体验,多种部署形态

一种经典体验,多种部署形态

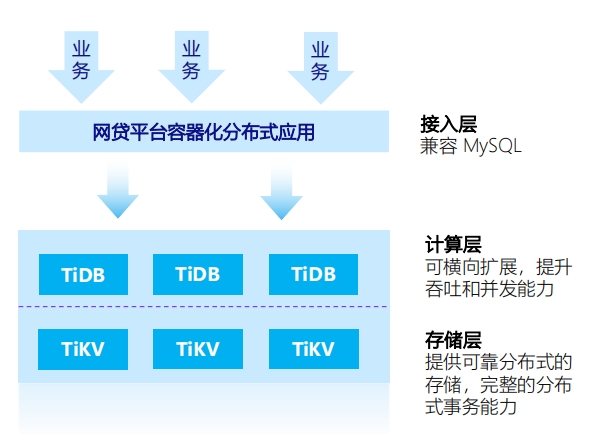

TiDB 核心组件

TiDB 核心组件

Raft 分布式一致性算法

Raft 分布式一致性算法

基本概念:Raft 是一个多数派协议,不会出现脑裂的问题。正常运行的情况下,会有一个 leader,其他全为 follower。Follower 只会响应 Leader 的请求。客户端的请求则全部由 leader 处理。即使有客户端请求了一个 follower 也会将请求重定向到 leader。

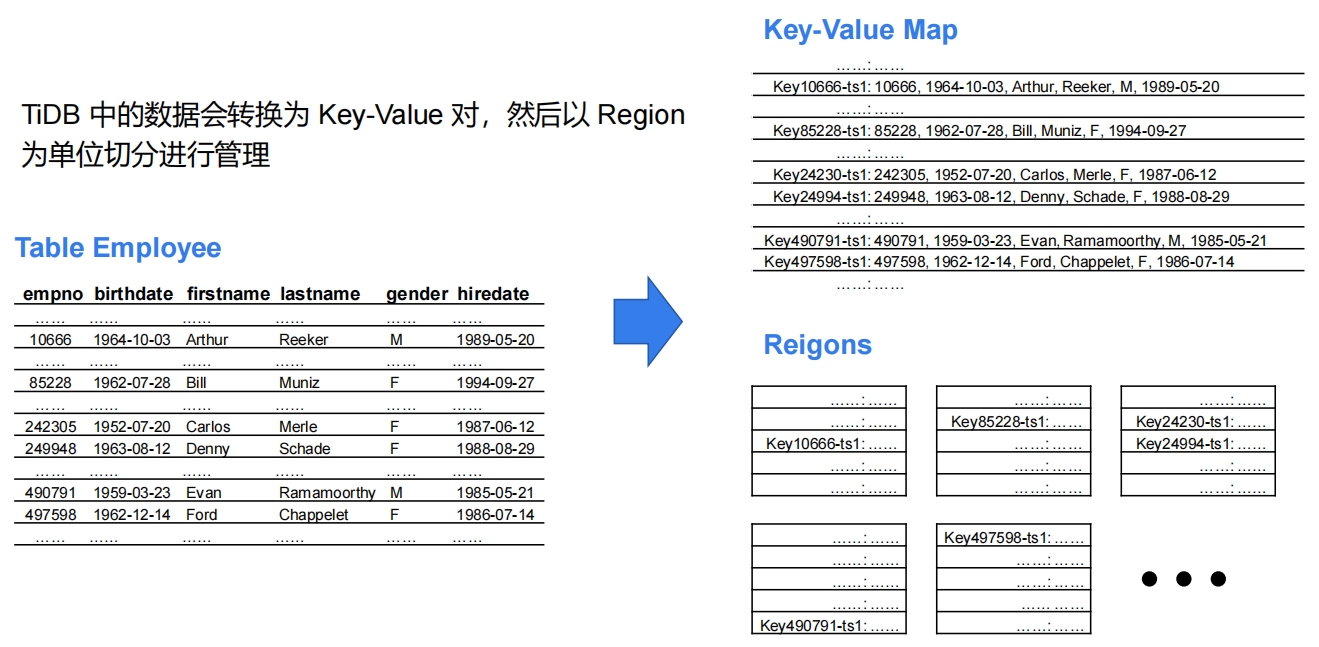

全局动态有序的 KV Map

全局动态有序的 KV Map

Region

Region

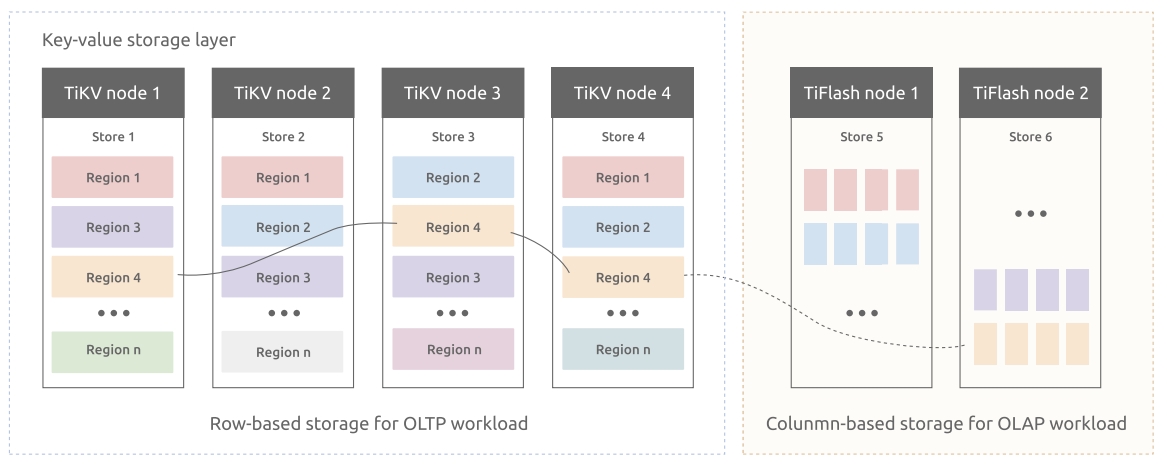

TiKV

TiKV

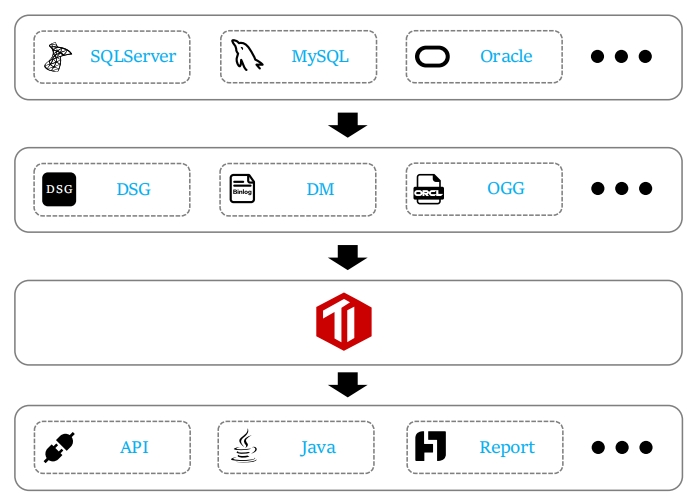

TiFlash

TiFlash

TiKV & TiFlash

TiKV & TiFlash

隔离性:列存副本以特殊角色 (Raft Learner) 进行异步的数据复制。这表示当节点宕机或者网络高延迟等状况发生时,交易的业务仍然能确保正常进行。一致性:每次收到读取请求,列存副本会向交易副本发起进度校对,只有当进度确保至少所包含读取请求时间戳所覆盖的数据之后才响应读取。

TiDB

TiDB

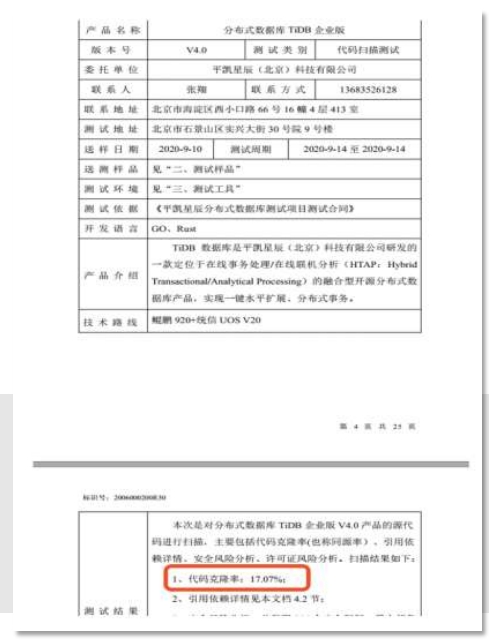

PD

PD

元数据管理

元数据管理

集群自动调度

集群自动调度

实现第一类需求后,整个系统将具备强大的容灾功能。实现第二类需求后,可以使得系统整体的资源利用率更高且合理,具备良好的扩展性。

标准集群拓扑

标准集群拓扑

TiDB 特性

TiDB 特性

TP 场景

TP 场景

用户中心

用户中心

商品、内容与物料

商品、内容与物料

订单与支付类

订单与支付类

明细、历史数据等综合查询类

明细、历史数据等综合查询类

IM 与通信互动类

IM 与通信互动类

适用场景

适用场景

vs 分库分表

vs 分库分表

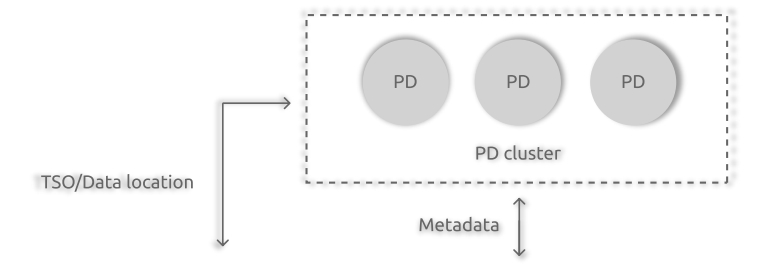

AP 场景

AP 场景

数据汇总层(明细/汇总报表)

数据汇总层(明细/汇总报表)

数据汇总层(跑批/待加工

数据汇总层(跑批/待加工

数据集市层

数据集市层

优势场景

优势场景

传统数据中台架构的短板

传统数据中台架构的短板

HTAP 场景

HTAP 场景

HTAP

HTAP

中通快递

中通快递

小红书

小红书

浦发银行

浦发银行

TiDB 产品定位

TiDB 产品定位

产品推荐

该产品基于指纹识别、人脸识别技术,可结合ID卡和密码形成多重组合交叉验证,精准确认用户身份,实用性高、安全可靠,可广泛应用于金融、教育、社保、军队、公检法、智能楼宇等行业的考勤管理以及重点区域的门禁安全控制。

首页

首页