无问芯穹企业级大模型服务平台

大模型服务平台

大模型服务平台

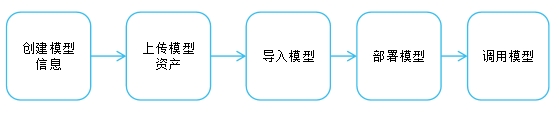

· 无问芯穹大模型服务平台基于无问芯穹的智算云平台

· 针对生成式大模型的应用落地的多种场景需求,为应用开发者提供高性能、易上手、安全可靠的

· 大模型服务,覆盖从大模型开发到大模型服务化部署的全流程。

MaaS核心优势

MaaS核心优势

Serverless服务,助力一键式、极低成本的大模型&AI应用开发。

大模型服务平台 - 亮点功能

大模型服务平台 - 亮点功能

大模型服务平台 - 亮点功能

大模型服务平台 - 亮点功能

大模型服务平台 - 亮点功能

大模型服务平台 - 亮点功能

场景1:大模型应用业务的模型匹配

场景1:大模型应用业务的模型匹配

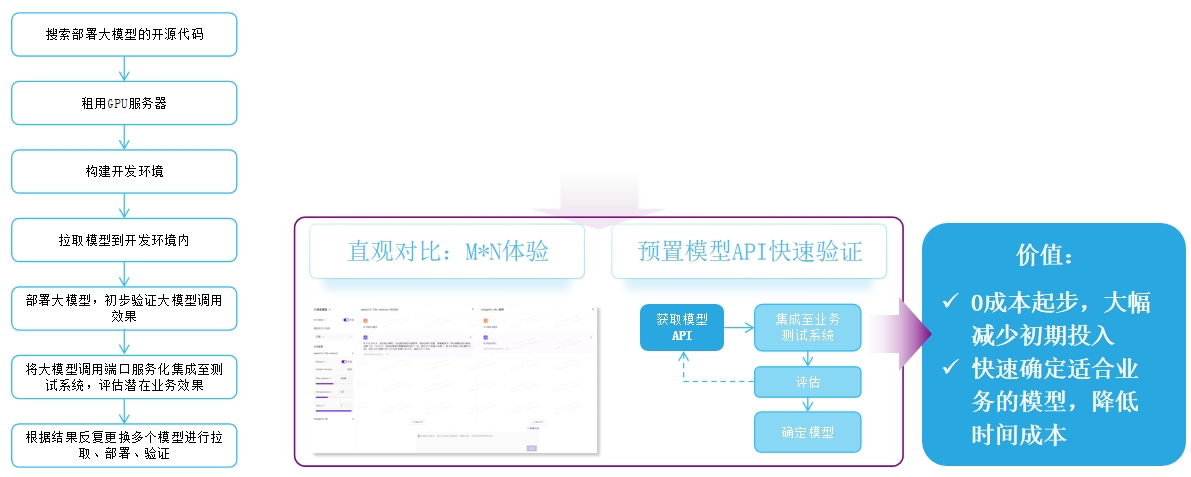

某公司新业务起步时,前期需要选择基座LLM,通过比对各种来源各种版本的数十种模型,每个模型从部署到验证都得经过大量的准备工作,并且需要完整的算力资源支撑,带来较高的启动成本。

痛点:模型选择比对过程繁琐且不直观

解决方案:平台直接对比,快速调用验证

· 平台直接对比:M*N功能支持输入提示词后直接查看所选预置模型的横向效果对比;

· 快速调用验证:3支持常见开源模型的服务预部署,开发人员可以通过API快速将多个不同模型接入业务进行验证。

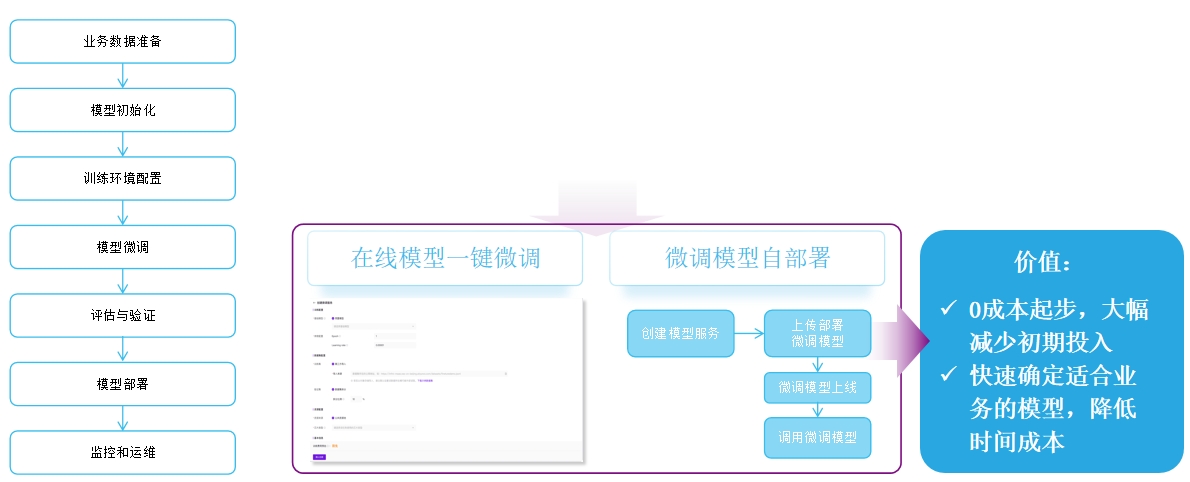

场景2:业务应用效果微调

场景2:业务应用效果微调

某公司作为某行业的头部企业拥有大量业务数据,想对模型进行微调,但算法人员能力相对不足且人力有限;随着业务逐渐发展,微调模型种类随着业务线增加到了20多种,此时模型部消耗了大量的资源,并且每次版本更新都让业务人员十分头痛。

痛点:模型微调要求高,多业务场景下部署及管理模型难

解决方案:1、提供简单易上手的微调服务;2.云端部署型,可按用量收费

· 支持在平台上传数据集进行在线微调,并预置了常用参数供用户调整,每个参数平台会提供不同的数值范围和默认值,可大大降低微调技术门槛,并且微调完的模型可以直接在平台上部署成服务。

· 微调完成后一键平台部署,可直接调用。

· 仅需上传LoRA权重,便可进行按量计费的调用,无需关心LoRA部署占用的资源。

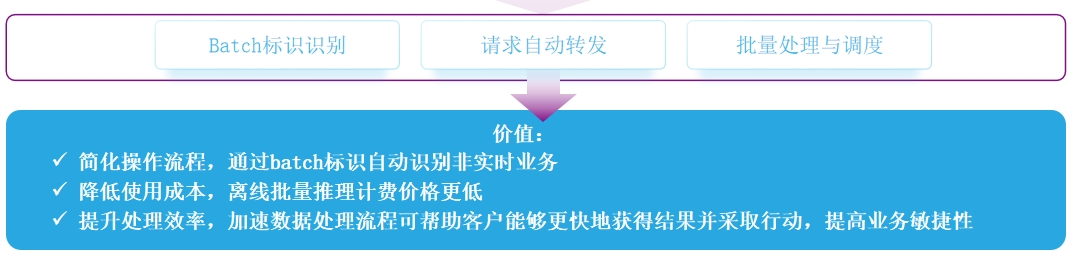

场景3:大批量离线推理

场景3:大批量离线推理

某公司有个业务是简历的理解,大量的同步长文本请求对服务器的负载增大,影响了平台的整体性能。由于这个场景对实时性要求不高, 业务负责人希望能够在不修改现有实时请求脚本的情况下,将那些可以延迟处理的任务迁移到离线批处理环境中,以提高处理效率并降低成本。

痛点:脚本重构困难,数据上传繁琐

解决方案:通过添加batch标识,平台对请求进行自动转发进行处理;

· 客户无需面向batch API要求重新编写请求脚本,仅需要简单改动现有脚本、添加标识符即可通过系统自动转发到batch API进行批处理。

· 客户无需整理batch数据上传到OSS,降低数据准备投入成本、数据存储成本。

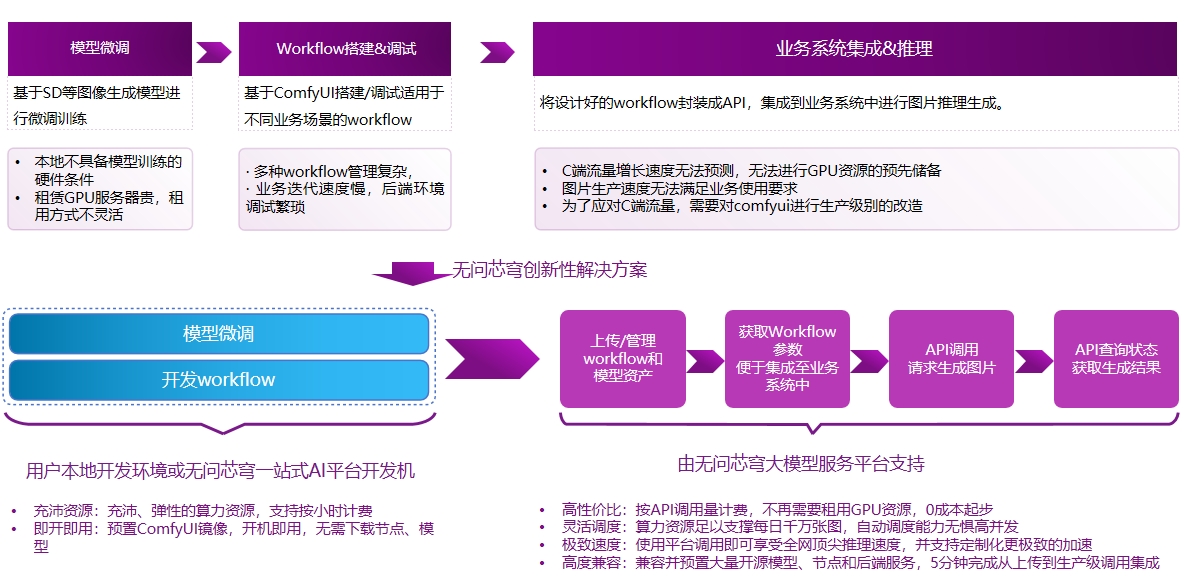

ComfyUl:AI图像生成场景

ComfyUl:AI图像生成场景

在AI图像生成应用的搭建上,越来越多的企业选择用comfyUI工具+SD、Flux模型作为基础,而从初始的模型训练、工作流搭建调试以及最后业务系统集成的各个阶段,会由于技术瓶颈、资源短缺等导致产品使用体验差、迭代周期长等问题。

客户案例

客户案例

蜂鸟AI是一家专注于电商领域的AI公司,旨在为电商平台和商家提供高效、高质量的图片AI处理服务。提升商品图片的视觉效果,增强购物体验,从而提高转化率和销售额。

租赁GPU资源贵,资源预备难

伴随着业务流量的上升,蜂鸟AI面临着算力需求激增的压力。传统的算力租赁不仅成本高昂,而且难以根据业务情况预先储备GPU资源。

端到端生成速度无法满足产品要求

随着业务领域的拓展以及业务体量增长,蜂鸟AI推出了更多的新功能,新功能具有更多的节点、更复杂的workflow,图片生成时间过长,无法满足业务使用需求。

解决方案及价值

无问芯穹基于大模型服务平台提供了工作流托管解决方案:

· 蜂鸟AI通过将其workflow、模型上传至平台进行托管,实现了工作流的一键上传、统一管理,不再需要花精力进行后端环境调试和管理。

· 将API集成到业务代码中,完成了托管及调用集成后,后续使用平台的企业级调用服务,波谷不再担心算力浪费,波峰不再担心请求拥堵。

· 基于大模型服务平台的加速能力,以及无问芯穹进一步的定制化加速服务某个工作流的图片生成时长下降了90%,满足业务使用需求,保障了业务的顺利上线。

日均生成图片:10万+张

波峰生成图片:5分钟2000张

推理速度提升:92%

成本下降:95%。

产品推荐

首页

首页