腾讯在控本提效的三个方案研究

腾讯在控本提效的三个方案研究

云原生环境下对高/低优先级作业进行混合部署,统一调配计算资源。

利用先进的内存后备设备,扩充内存

能力。

智能内存回收,避免内存雪崩。

多级内存沉降,降低配置成本。

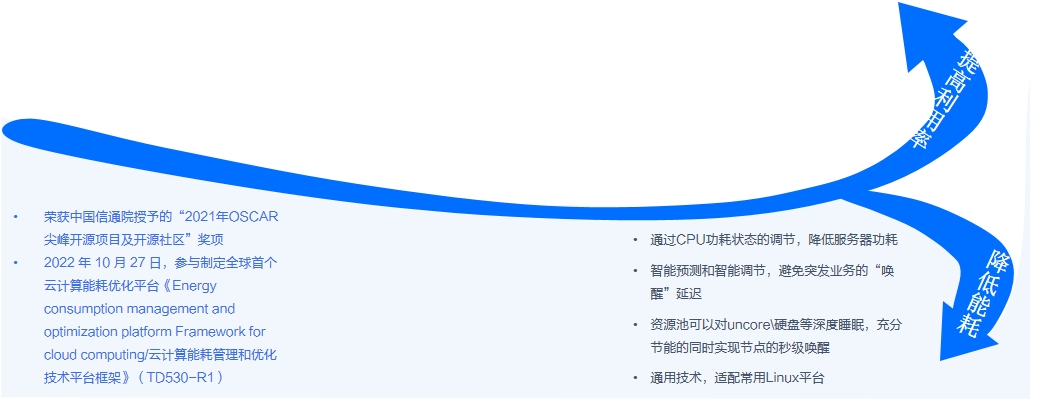

腾讯能耗节省-悟能方案概述

腾讯能耗节省-悟能方案概述

>弹性cpu策略,基于cstat,让空闲CPU核进入深度睡眠C6状态。

>预留X倍核心,快速扩核逻辑,应对业务变化和突发增长。

uncore节能

> Uncore:cpu的uncore部分设置为最低频率。

>Cpufreq:切换到最低频率。

>磁盘休眠:让scsi盘闲置时休眠。

>适用于长期低负载,无业务部署,可以快速切换到性能模式(秒级切换)。

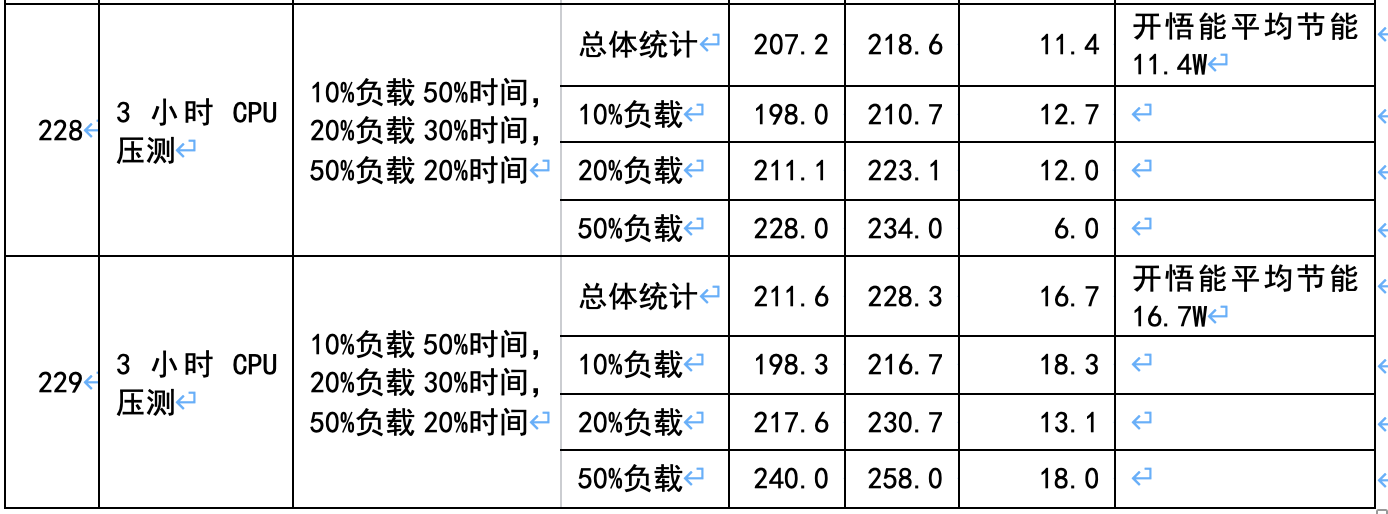

某客户悟能测试结果汇报

某客户悟能测试结果汇报

测试环境中4台物理服务器,分别通过sysbench和mysql压力测试,按照一定比例进行压力测试,记录对比“开”、“关”悟能的能耗差异。

测试结果

(1)服务器BIOS开启Performance模式时,开启悟能后,平均节能11~16W,

(2)服务器BIOS开启Performance模式时,开启悟能后性能损耗小于5%。

(3)服务器BIOS开启conservative模式后的性能相比Performance模式损耗

(4)服务器BIOS开启conservative模式时,开启悟能后能耗平均上升26瓦,约

结论解读

(1)服务器BIOS建议设置为Performance模式,避免较大的性能损失。

(2)使用悟能的CPU节能模式,平均节能5%~7%(目前平均负载为21%),如果真实服务器日平均负载小于20%,可获得较好的节能效果。

(3)当前悟能测试了cpu的节能效果,在一些环境中,可以启用uncore的节能设置,节能效果更好(闲时让服务器整体进入“浅睡眠”状态)。

腾讯悟能内部使用效果

腾讯悟能内部使用效果

腾讯TEG机器总数60万台,主要采用CPU节电模式,日节电2.5万度

腾讯云机器总数约90万台,主要采用uncore节电模式,日节电19万度

目前混部方案的主要研究方向

目前混部方案的主要研究方向

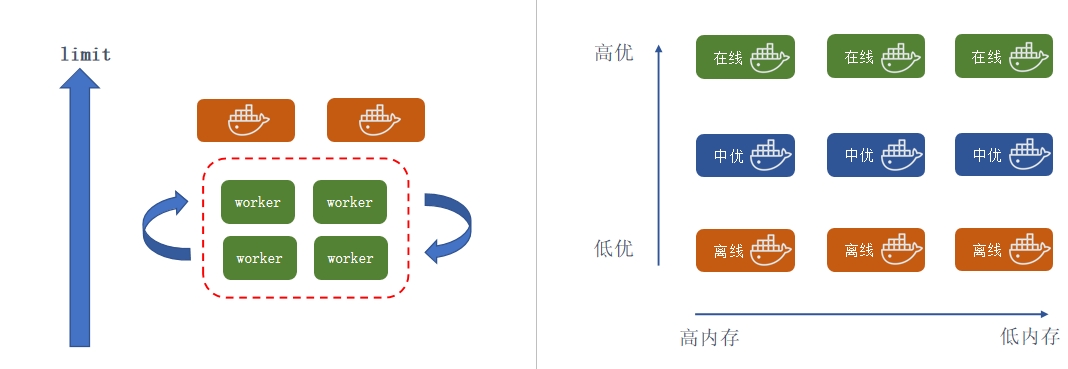

容器调度层面的混部

降低干扰率

拓宽应用场景

资源调配效率更高

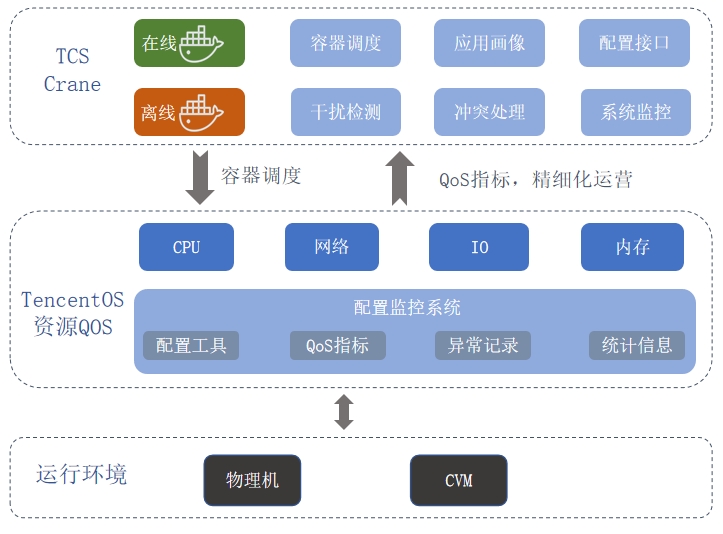

腾讯在离线混部解决方案框架图

腾讯在离线混部解决方案框架图

·延迟敏感、流量周期性、资源潮汐等。

离线任务:

·时延不敏感、计算量大等。

·视频转码、大数据、图片压缩等。

TKE/TCS 容器调度层面:

·离、在线作业调度。

·对资源使用情况进行预测和监控。

·解决冲突,离线驱逐。

如意内核层面:

·CPU、IO、网络 、内存全资源覆盖。

·高优作业保证服务质量。

·低优作业防饿死。

·为上层提供统计信息。

·丰富的ebpf监控工具集。

内核核心能力-CPU和内存

内核核心能力-CPU和内存

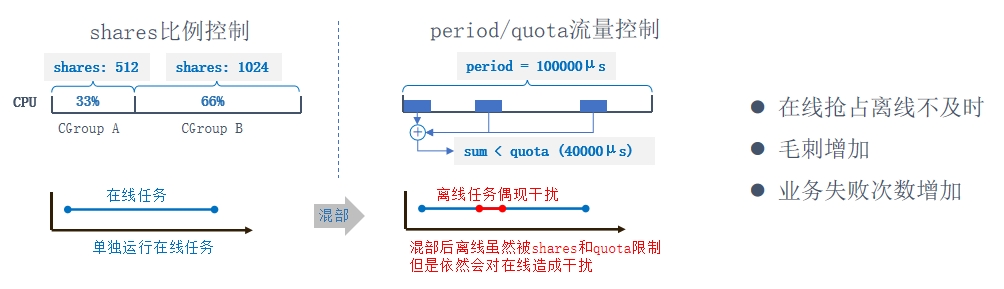

CPU QoS:CFS调度算法局限性

CPU QoS:CFS调度算法局限性

基于社区shares+period/quota方案

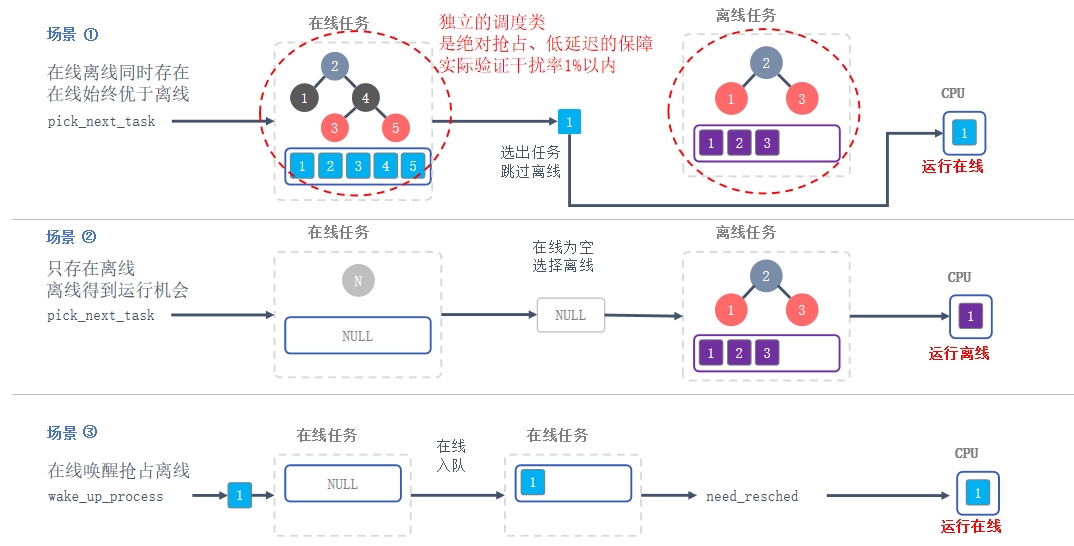

如意CPU QoS:BT离线调度类-绝对抢占

如意CPU QoS:BT离线调度类-绝对抢占

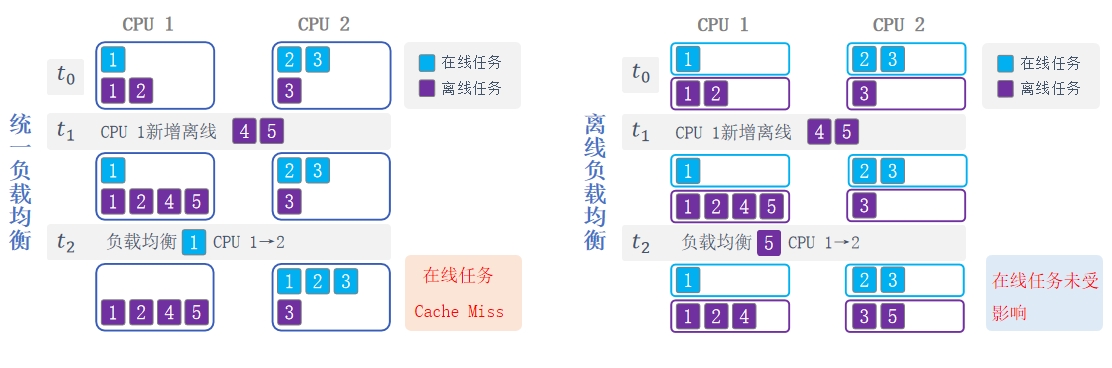

如意CPU QoS:离线负载均衡

如意CPU QoS:离线负载均衡

离线负载均衡

统一负载均衡:在线任务被离线任务影响,反复被迁移

离线负载均衡:对在线任务没有任何影响

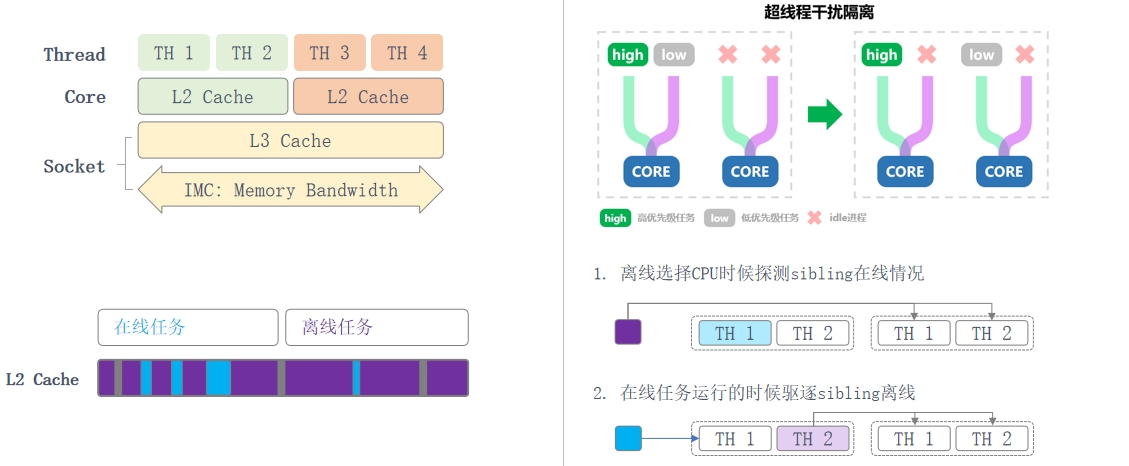

如意CPU QoS:超线程隔离

如意CPU QoS:超线程隔离

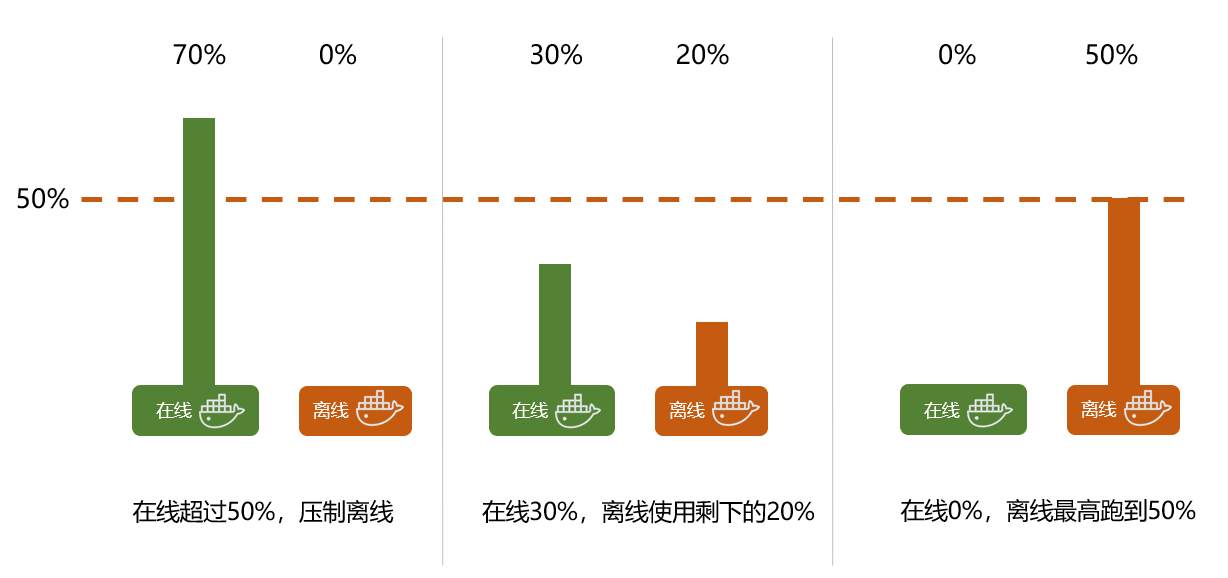

如意CPU QoS:离线压制水位线

如意CPU QoS:离线压制水位线

使BT支持CPU限额功能,可以根据需要灵活配置离线的份额

echo 50>/sys/fs/cgroup/cpu/test/cpu.bt_suppress_percent

风险防范,灰度部署离线任务

案例展示-CPU QoS:WXG(微信)某在线业务

案例展示-CPU QoS:WXG(微信)某在线业务

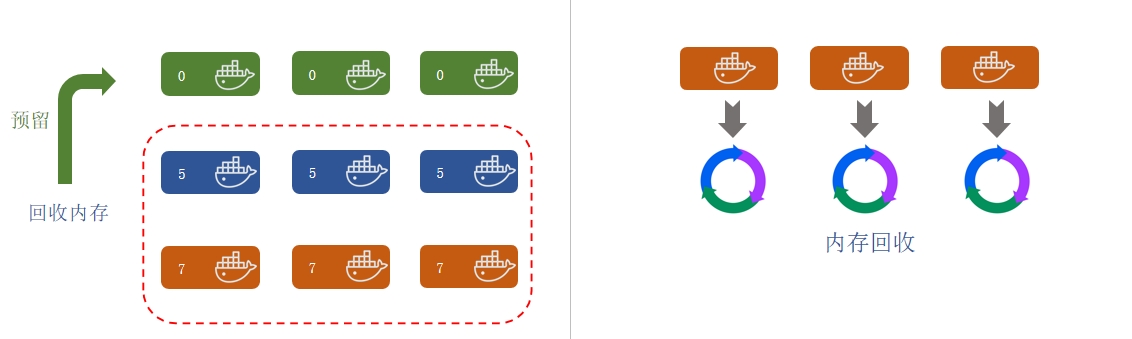

如意内存QoS

如意内存QoS

预回收中低优先级容器的内存,使得系统中保留一定量的空闲内存,保证高优容器的内存分配时延和成功率。

整机pagecache限制:限制服务器总体pagecache使用率。

·优先memcg 异步内存回收内存。

·OOM时根据容器优先级由低到高释放内存,保障高优容器的稳定性。

内核核心能力-网络和IO

内核核心能力-网络和IO

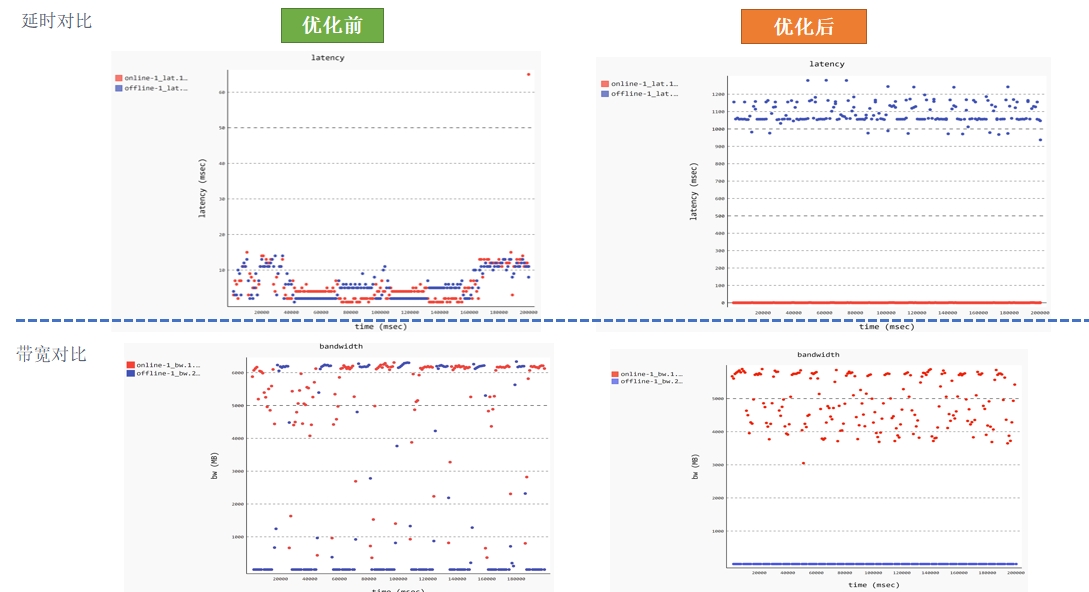

实际效果 IO QoS

实际效果 IO QoS

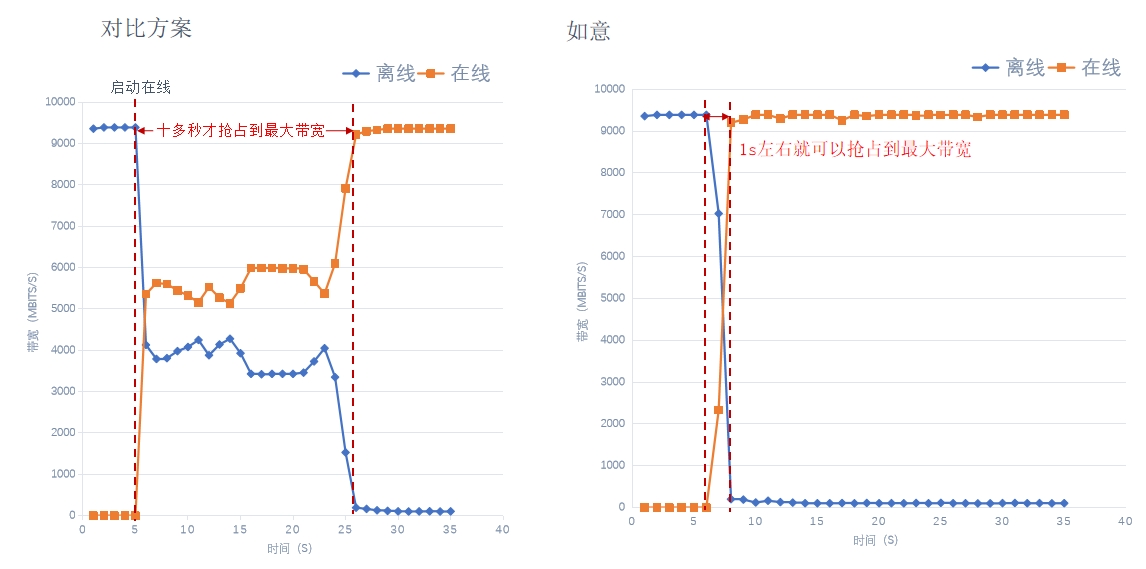

实际效果 网络QoS

实际效果 网络QoS

悟净-内存成本优化与可用性

悟净-内存成本优化与可用性

利用OS内核侧进行内存优化的天然优势,保障业务内存使用性能前提下,将较冷的内存换出至较便宜的设备上,从而降低整机的内存消耗,提高

内存资源利用率,通过平滑降配、负载调压、内存超卖等手段实现降本增效,助力业务和客户商业增值。

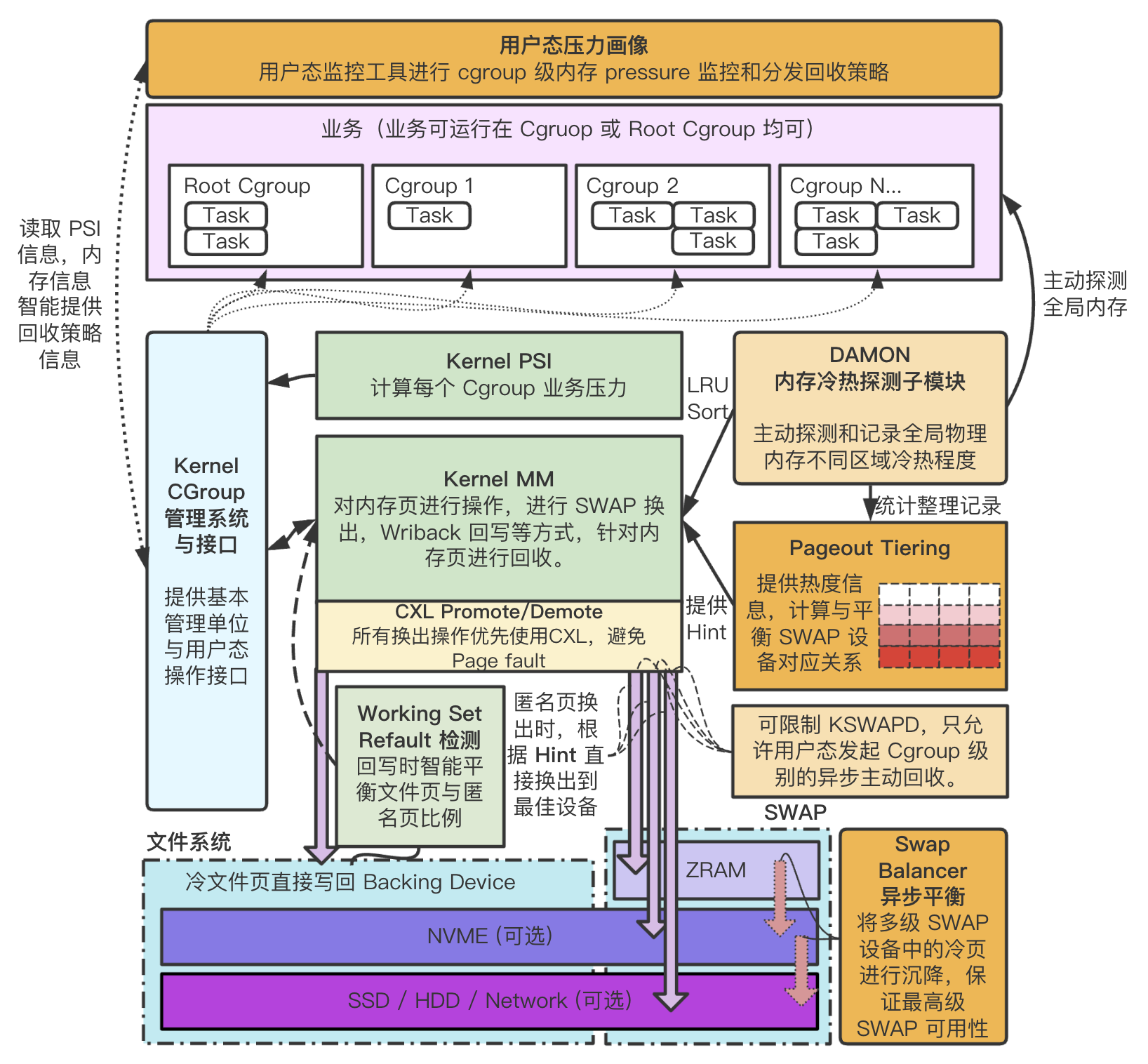

悟净核心技术实现

悟净核心技术实现

DAMON 核心及子模块:扫描出长时间未访问的页面,提供基本扫描框架与全局

Pageout Tiering 框架:在待回收的页面链表中,根据页面冷热频率(DAMON

SWAP Balancer 模块:每个 SWAP 后备设备维护 LRU 链表,当高级SWAP 设备

CXL 支持:在换出回写前,优先使用 CXLPromote/Demote,避免 PageFault、

核心性能优化:针对内核 MM 核心代码进行了大量调优和优化,部分已经upstream。

悟净的实际效果

悟净的实际效果

·平均节省内存量达到35%(不包含降配)。

·部署的在线业务包含xstore内存型数据库、自研VOIP以及QQ音乐搜索业务等。

业务特征:K8S+Spring cloud +Consul,Java高内存。

核心诉求:降低成本、提升资源利用率。

使用效果:内存使用量压缩至原来66%,性能无明显变化。

·联通

近期上线中。

移植到CULinux平台。

初步测试内存节省20%+。

算力优化,进入智算时代

算力优化,进入智算时代

传统推理场景的算力共享-qGPU

传统推理场景的算力共享-qGPU

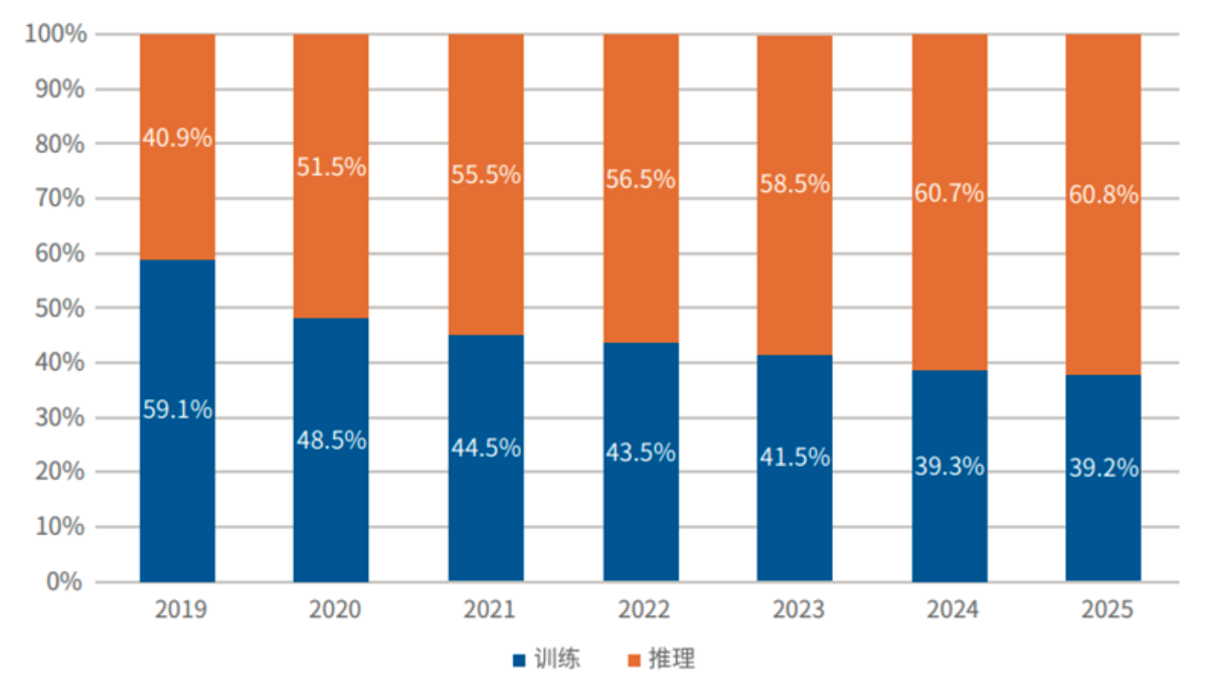

目前卡的计算能力也来越强,大部分推理场景GPU卡的利用率都比较低。

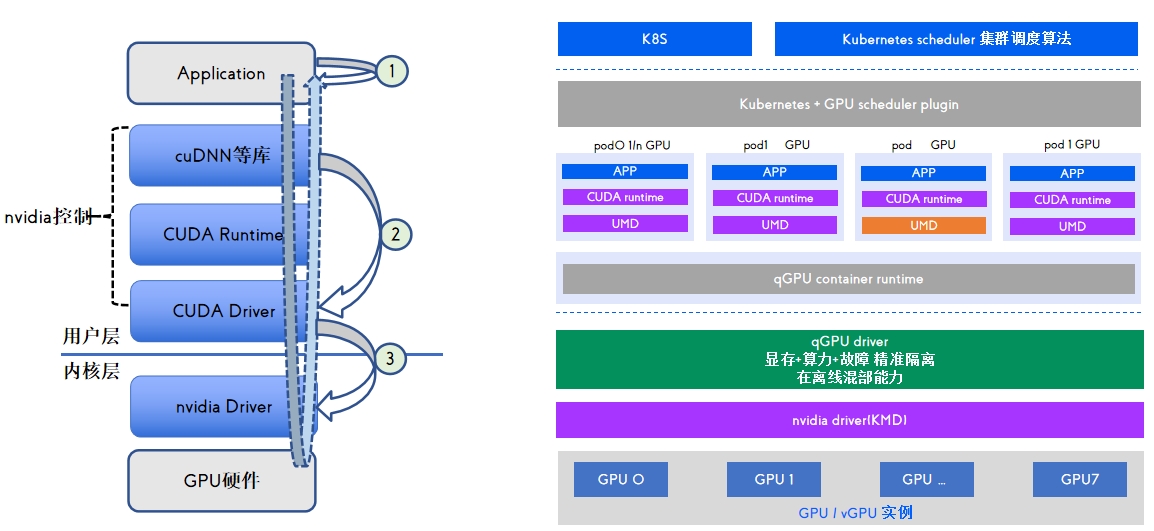

qGPU基于内核劫持的实现框架

qGPU基于内核劫持的实现框架

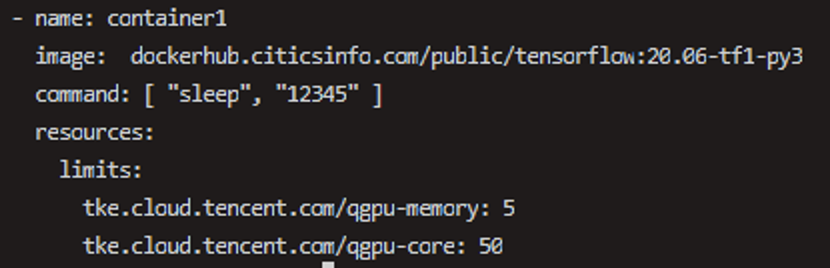

qGPU的主要特点

qGPU的主要特点

大模型推理加速框架-TACO-LLM

大模型推理加速框架-TACO-LLM

·寻求快速适配,简单部署,开箱即用的推理框架

·在延时不变的情况下,要求更高的吞吐性能

·客户对推理指标要求不同,需要个性化的优化手段

·客户要求不同的输出格式,例如openai,streaming等

自回归模型吞吐低 显存限制算力利用率低

首字母延迟,吞吐量

总时延

输入以及输出的序列长度不同,影响推理性能

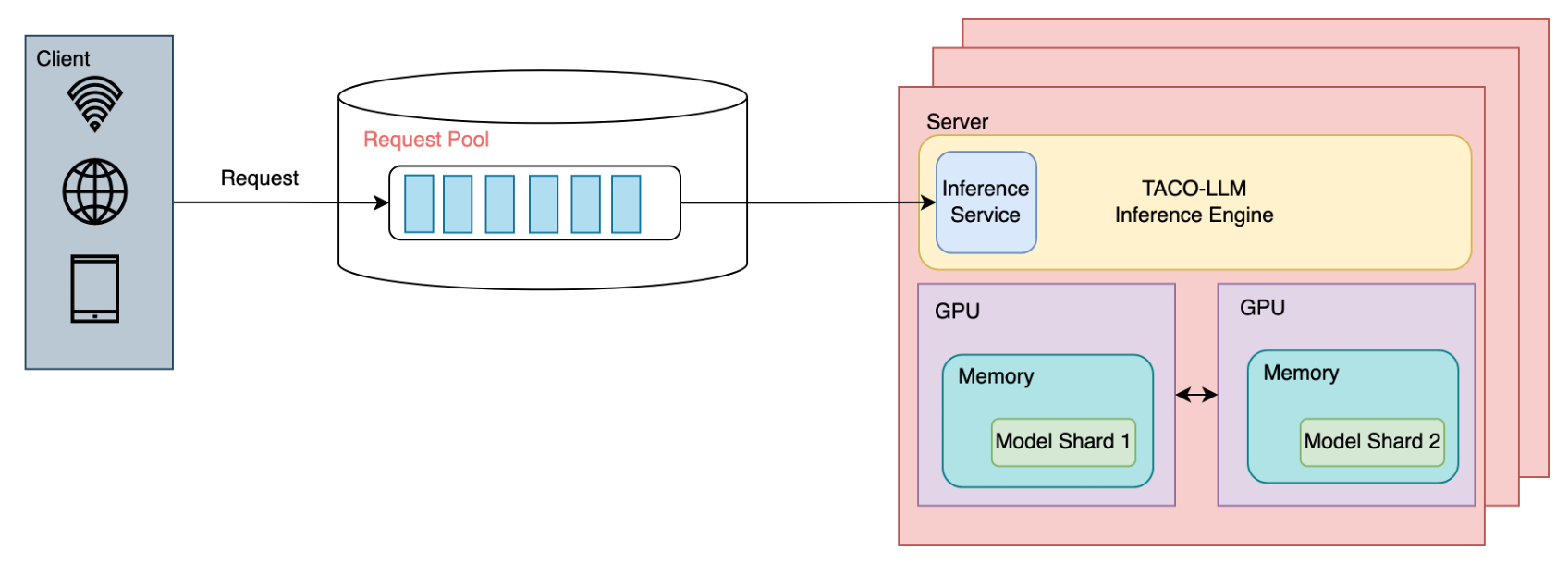

TACO-LLM解决方案

TACO-LLM作为腾讯云推出的一款易部署的大语言模型推理加速引擎,专注于解决客户诉求和推理难点:

易部署,开箱即用,全面兼容主流模型。

极致性能优化,降低生成过程延时,提高吞吐量,

面向生产落地,根据实际需求来调整推理策略

支持不同的算力和显存优化策略,充分利用算力设备,提高资源利用率。

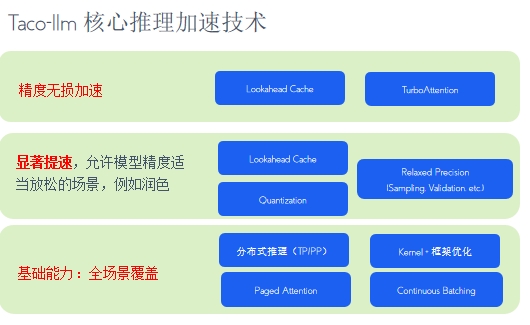

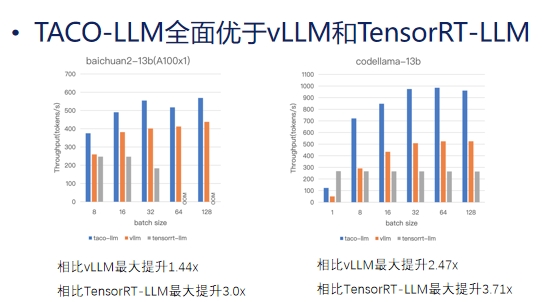

TACO-LLM主要技术和效果

TACO-LLM主要技术和效果

Inference Service:服务实例。按APIserving用户请求,同时处理多个序列输入并返回结果。

Inference Engine:高效执行模型的推理过程。

Model:部署在推理引擎中,较大时,分布式存储在不同GPU的显存上。

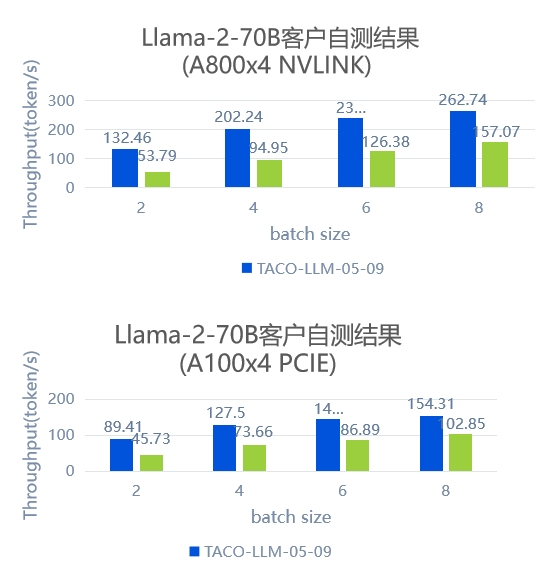

TACO-LLM落地业务案例-某头部视频网站

TACO-LLM落地业务案例-某头部视频网站

·客户要求超过 NVIDIA 最新版本 TensorRT-LLM 性能 50% 以上。

客户痛点

·弹幕数量较多,内容丰富,需要处理大量的长序列输入

·客户模型体量较大(70B+),超过单卡的显存容量,寻求更加高效的在线分布式推理方案。

性能优化结果

客户自测在 A800 上 TACO-LLM 相对最新版本 TensorRT-LLM 加速为1.67x~2.46x。

客户自测在 A100 上 TACO-LLM 相对最新版本 TensorRT-LLM 加速为1.5x~1.96x。

腾讯云Linux服务器操作系统CentOS迁移方案是,腾讯云针对 Linux 操作系统提供特定的根据用户的业务系统运行现状和规划,以及具体的迁移改造需求,选择合规、安全、可靠的技术路线,提供迁移的服务方案。

功能全面

便于操作

兼容性强

云耀云服务器( HECS)是可以快速搭建简单应用的新一代云服务器,具备独立、完整的操作系统和网络功能。

优化购买过程的复杂配置,减少选择信息

无需配置,可一键部署,满足建站、应用开发

集成多个华为云产品的功能