新一代分布式存储核心关键词

新一代分布式存储核心关键词

云海是京东全自研新一代分布式存储产品,兼顾集中式存储的稳定性和分布式存储高性能高扩展的优势。新一代分布式存储性能是Ceph商业化版本的5倍,成本是集中式存储的1/2。

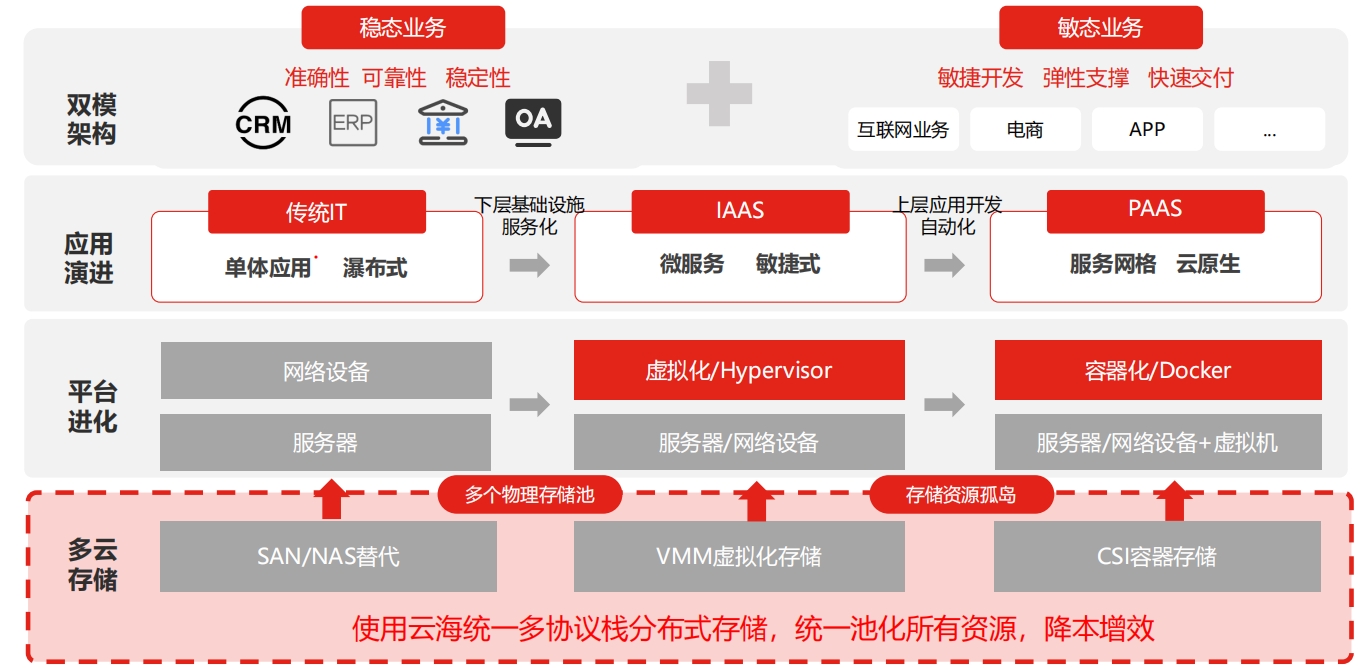

云原生存储的应用痛点和需求

云原生存储的应用痛点和需求

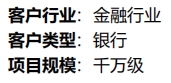

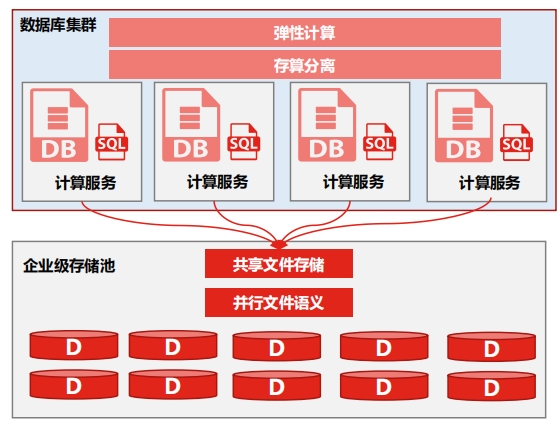

存储性能、稳定性、可用性、可靠性、单位成本等关键因素需要寻找平衡,故障恢复过程缓慢,恢复涉及大量数据拷贝,影响业务连续性。资源负载不均衡,容易产生热点问题,忙的忙死,闲的闲死。资源分配粒度过大,沉默成本高,对IT投入不友好。弹性资源可持续交付,秒级扩缩容,有效应对业务波峰波谷。计算存储解耦,各自按需使用,降低成本。有效解决资源孤岛,共享模式,突破单机资源瓶颈。

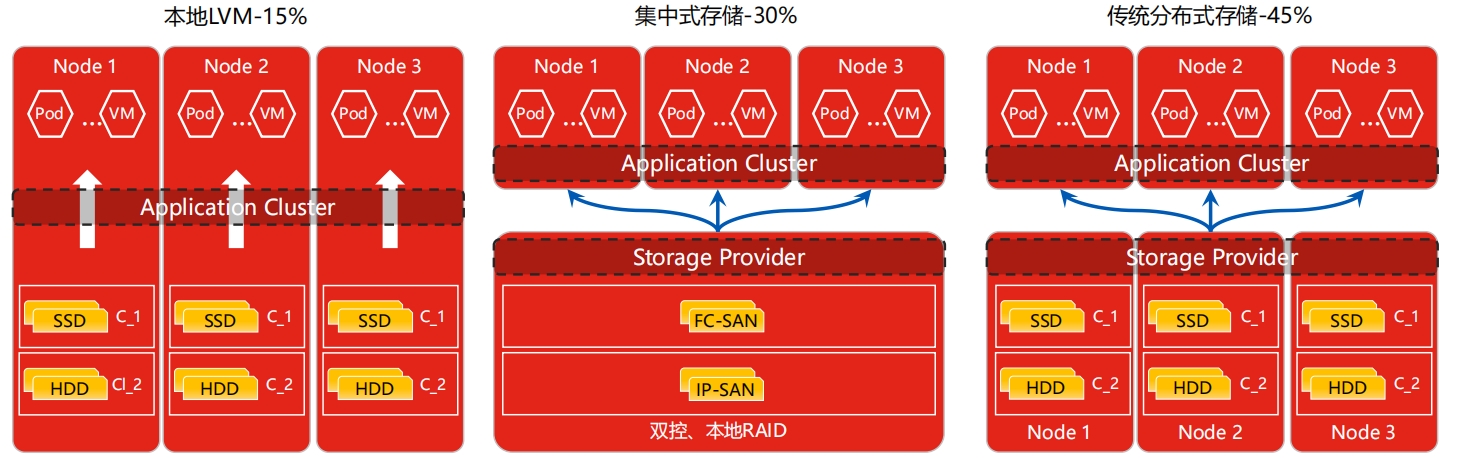

传统分布式存储面临的挑战

传统分布式存储面临的挑战

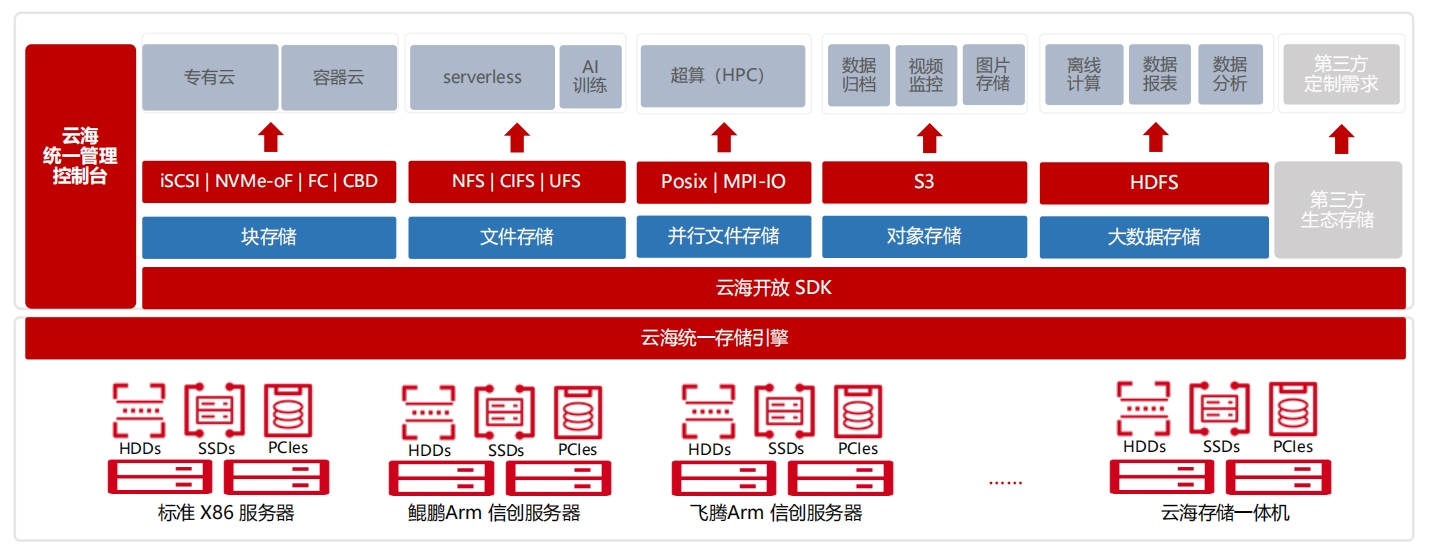

新一代分布式存储产品全景 - 云海

新一代分布式存储产品全景 - 云海

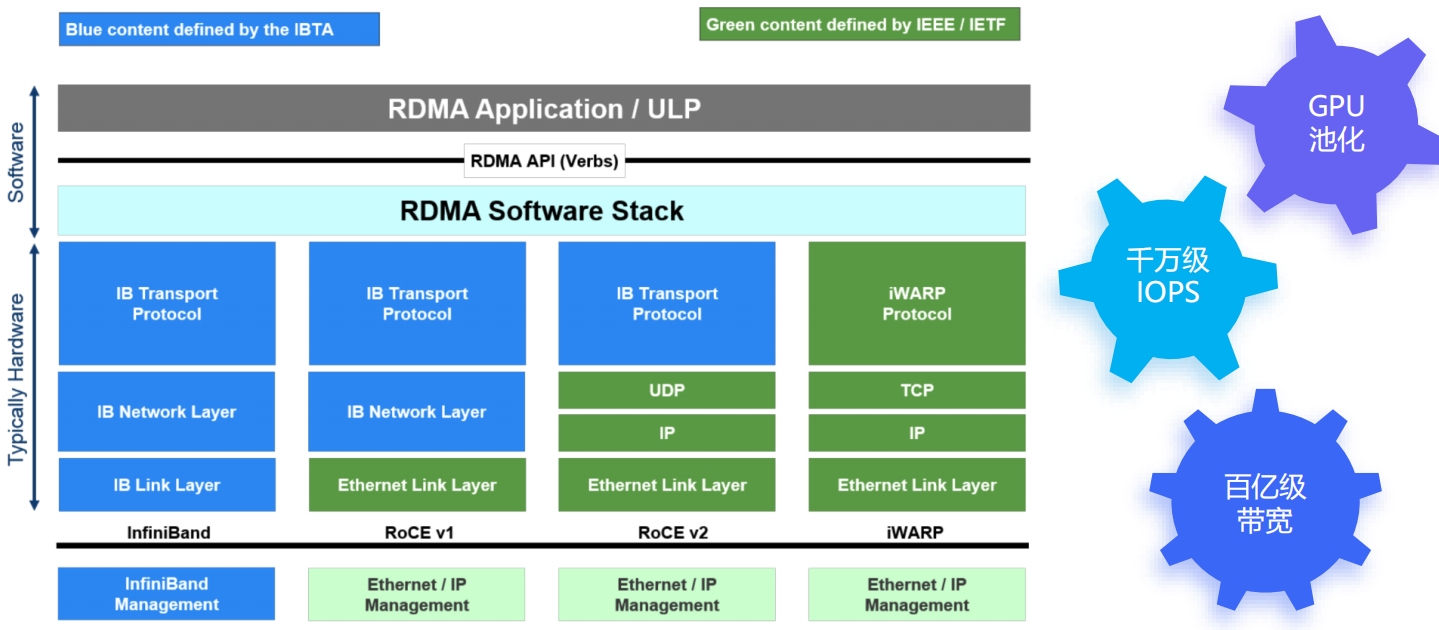

新一代全自研分布式存储云海,借助超低延迟RDMA网络、用户态NVMe、SPDK全新存储架构,提供高性能、低成本、高可用的一体化存储方案,支持容器CSI、虚拟化、信创,全面兼容k8s、openstack和主流云厂商,助力客户业务全面上云。

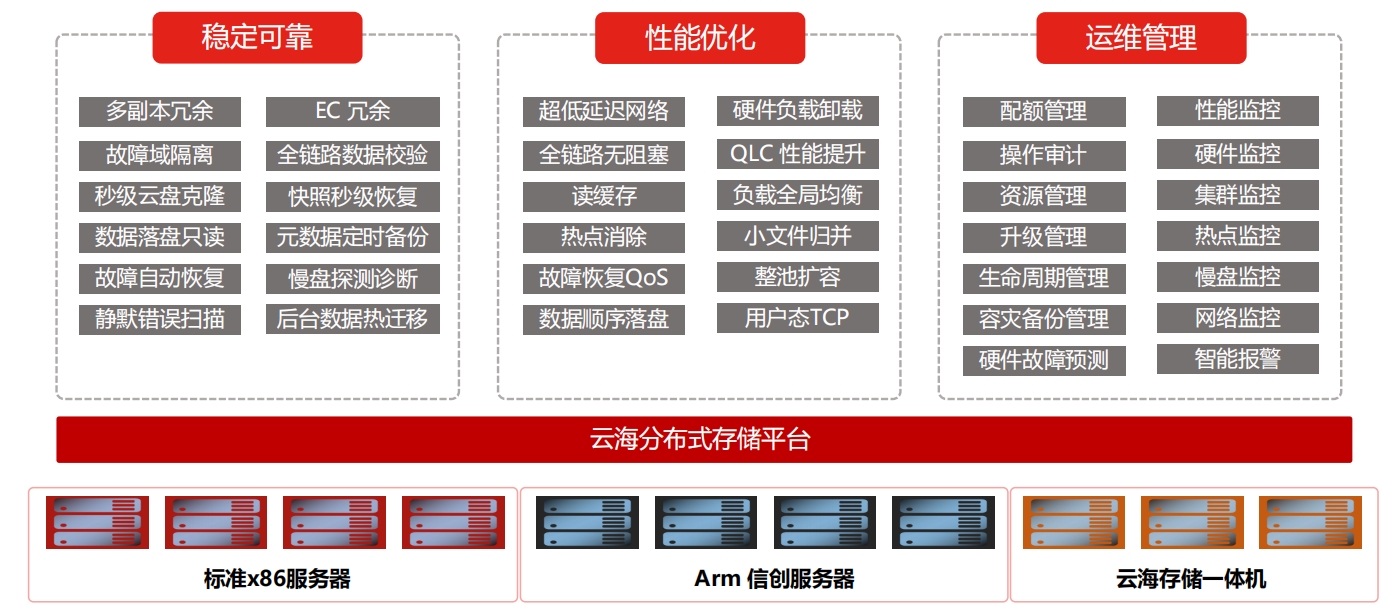

运维管控

运维管控

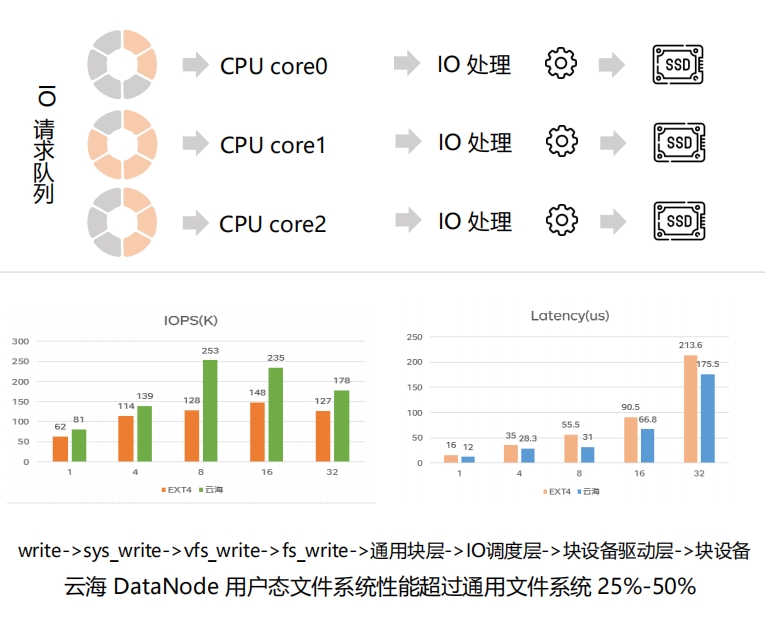

高性能

高性能

高性能

高性能

高性能

高性能

高性能

高性能

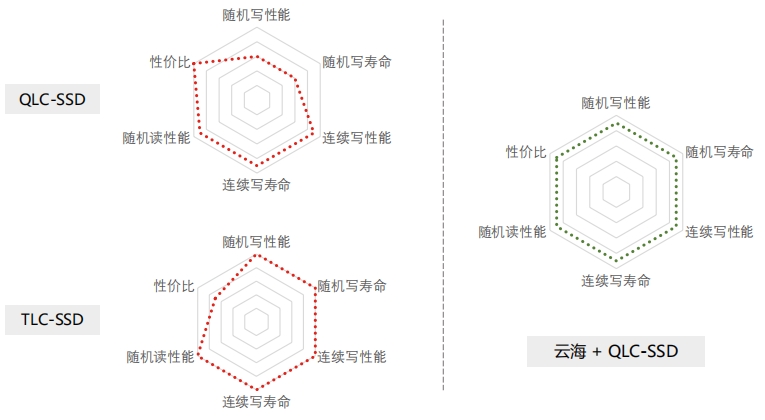

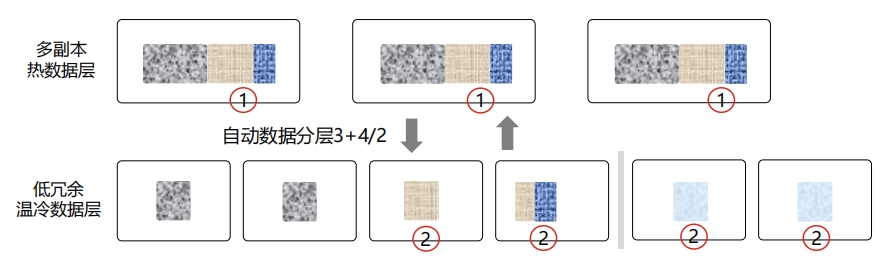

低成本

低成本

低成本

低成本

高可用

高可用

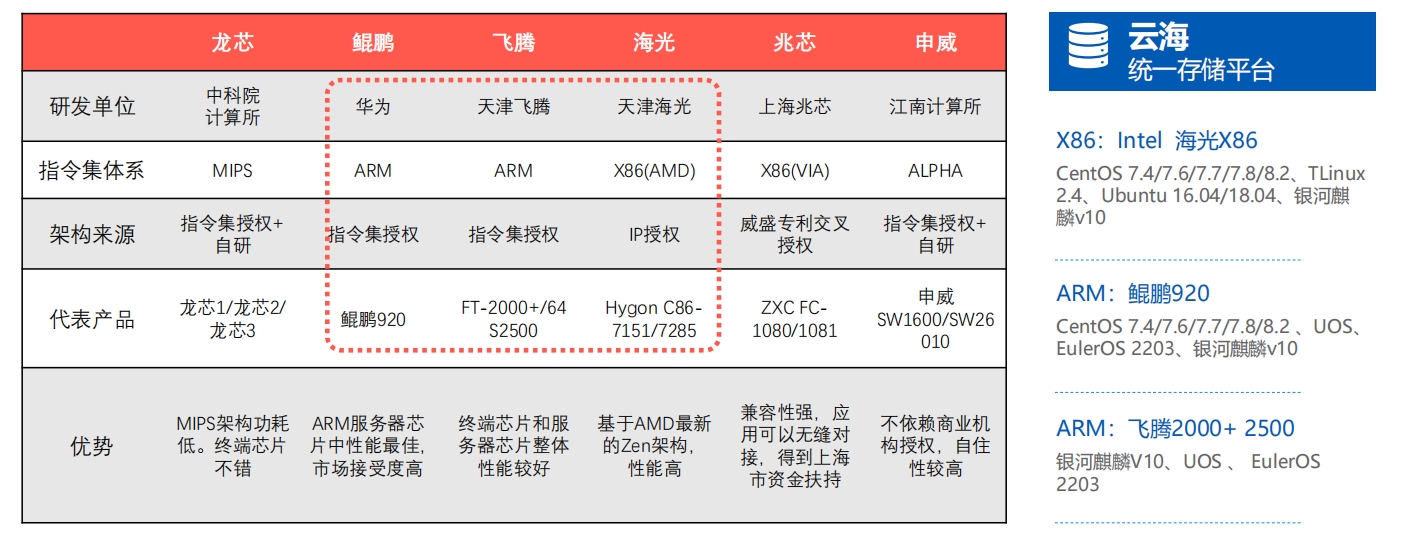

信创技术

信创技术

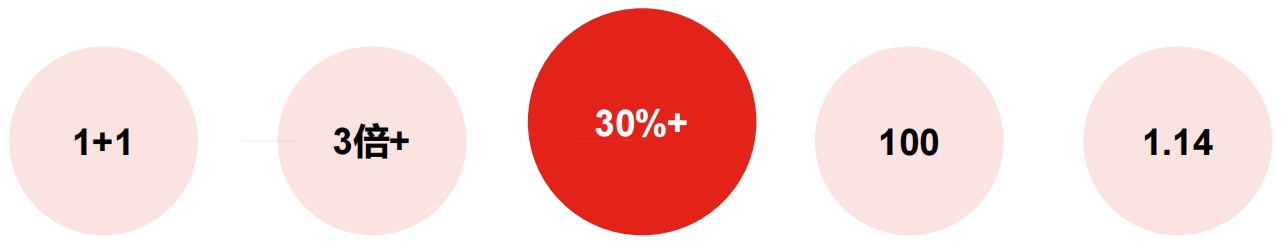

客户收益

客户收益

交付形态

交付形态

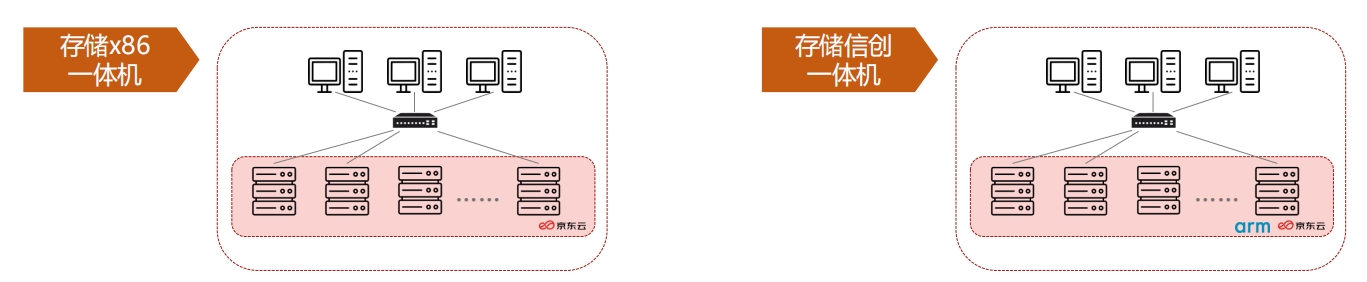

云海产品优先建议以 x86/信创 一体机模式交付,为客户交付开箱即用的产品。一体机模式下,云海预装在京造服务器上,按需求容量部署交付到客户机房。云海存储一体机经过完善的线下规格验证,可以为客户提供最佳的性能/稳定性体验。

分布式存储架构痛点

分布式存储架构痛点

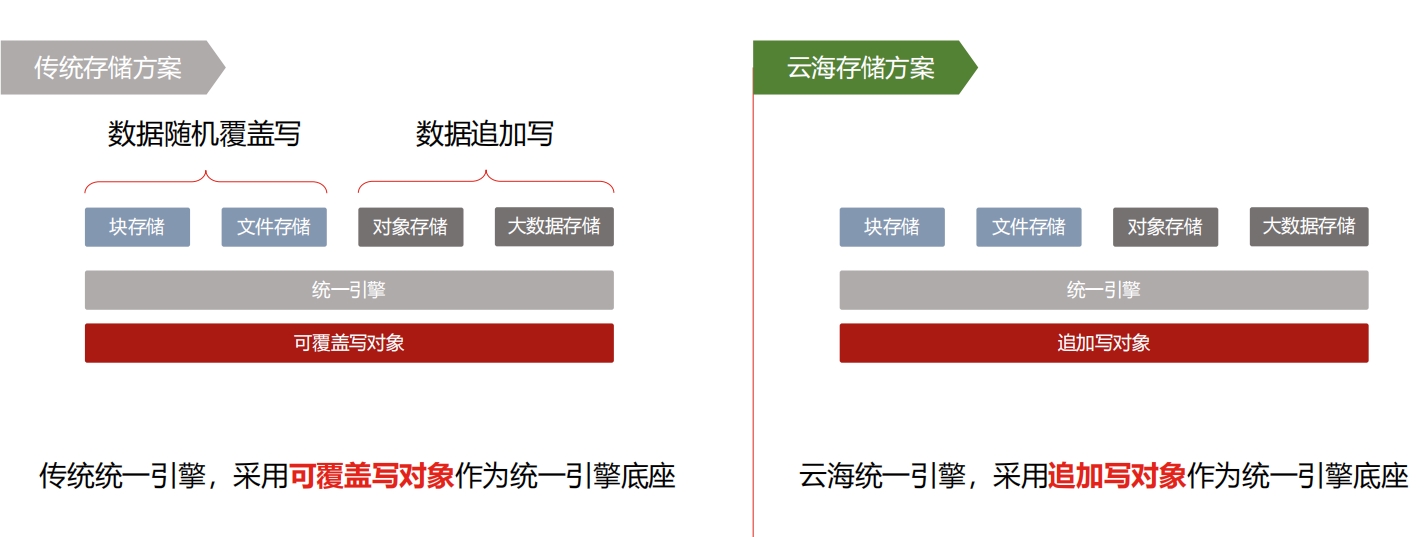

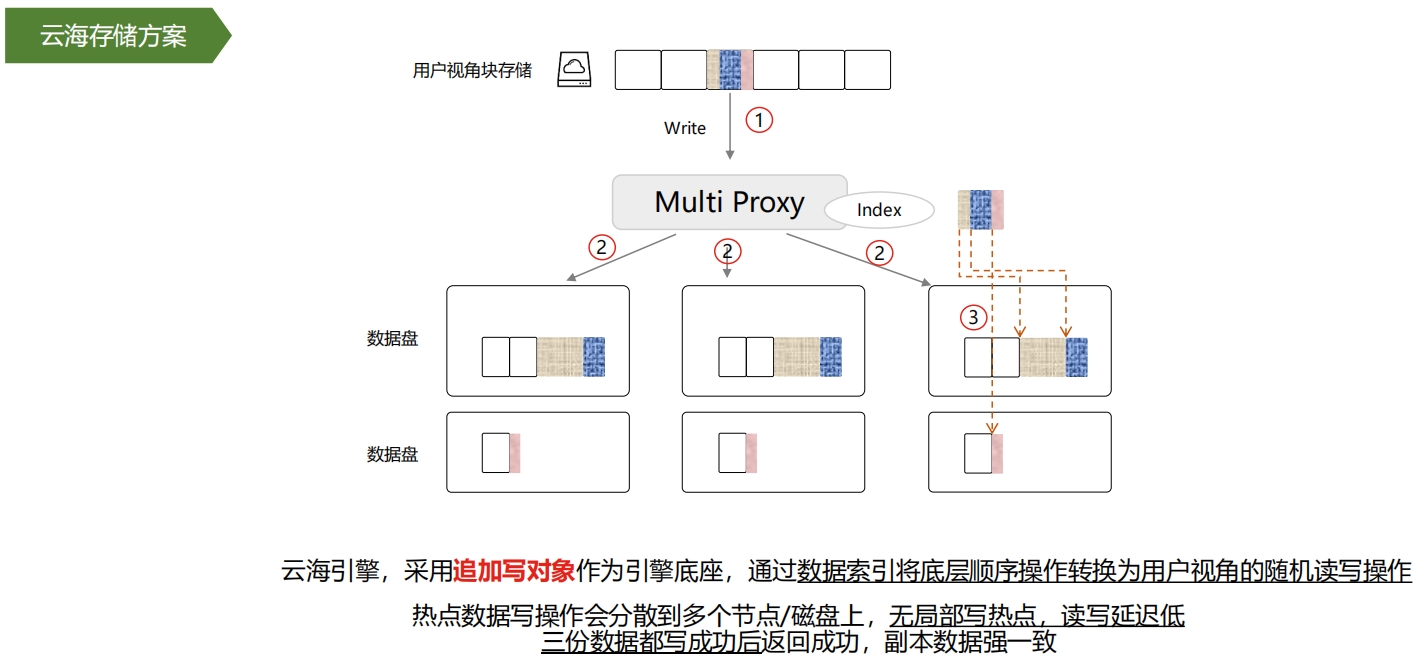

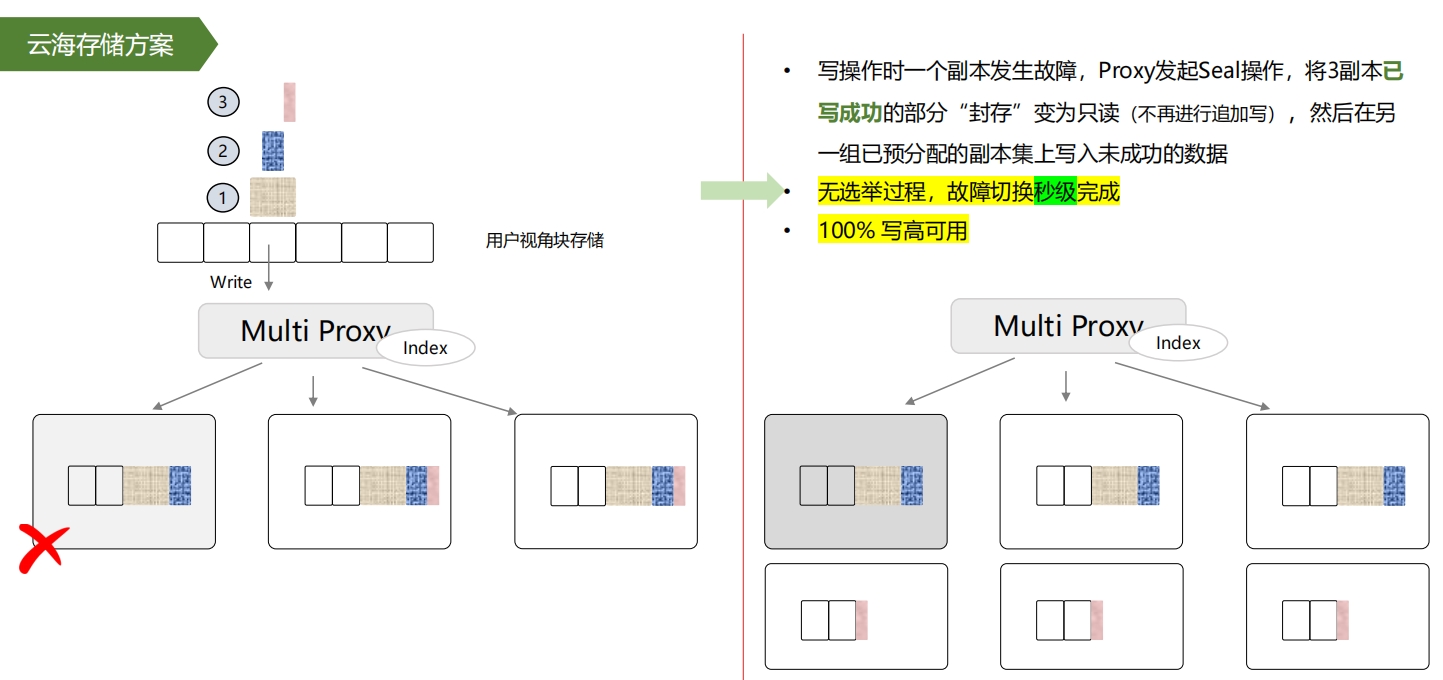

基于追加写的统一引擎机制

基于追加写的统一引擎机制

存储引擎设计差异,带来领先的技术产品

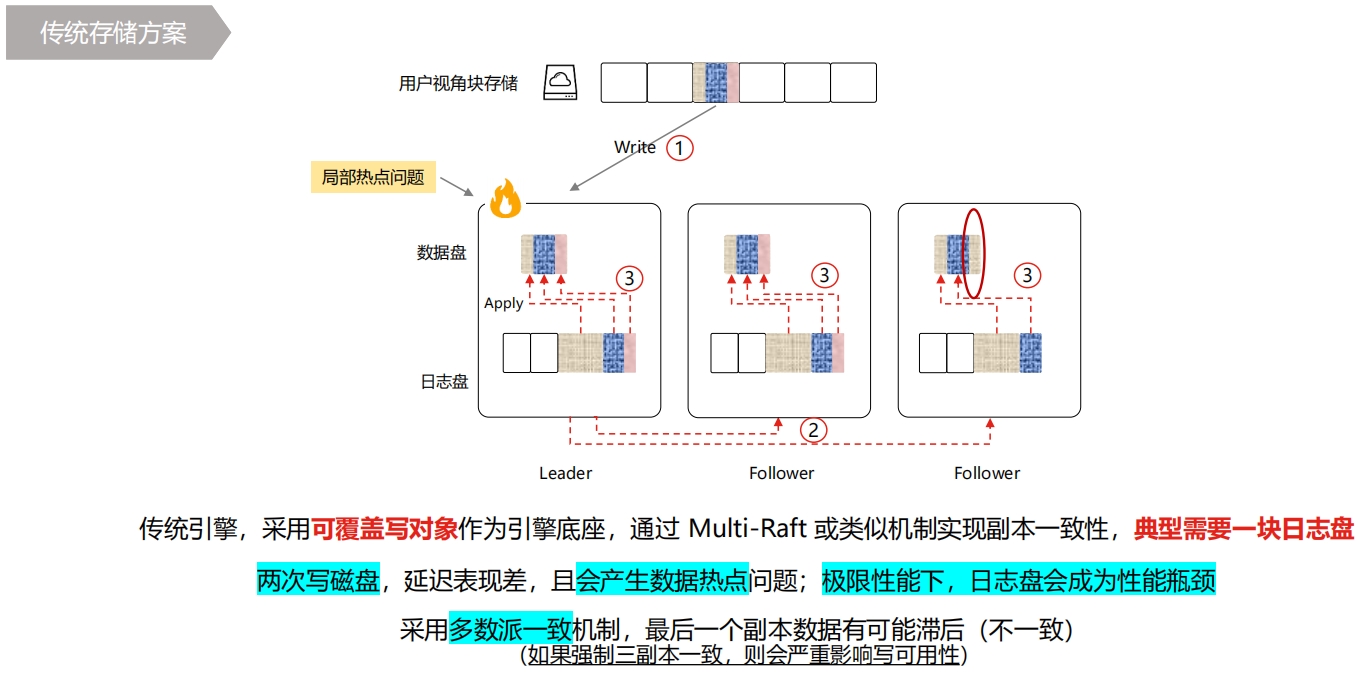

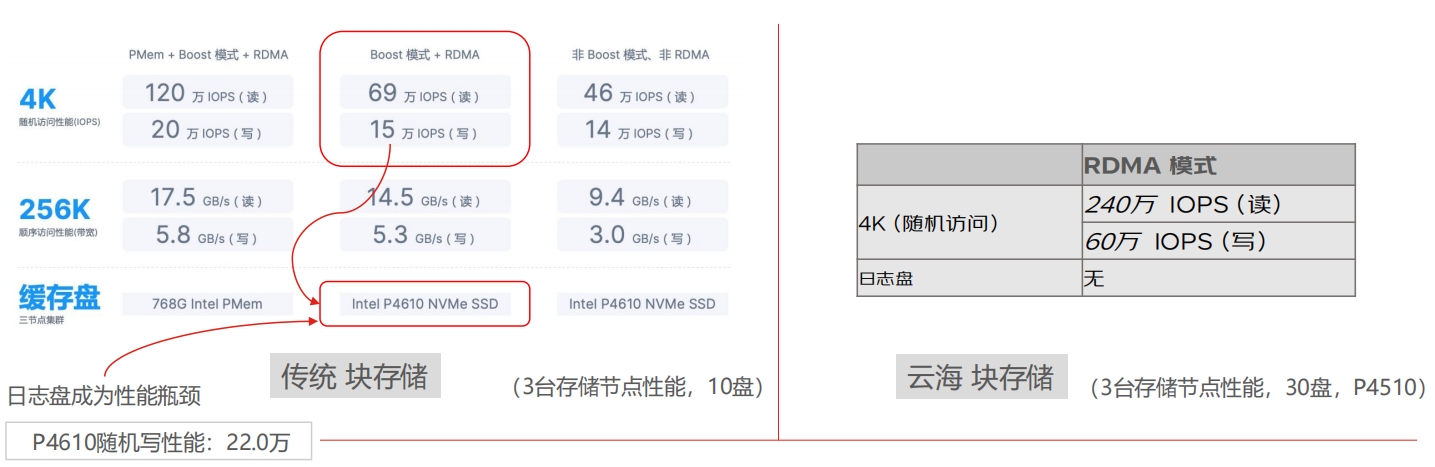

数据写机制

数据写机制

数据写机制 和传统高性能分布式存储厂商的读写性能数据对比

数据写机制 和传统高性能分布式存储厂商的读写性能数据对比

数据写机制

数据写机制

数据读机制

数据读机制

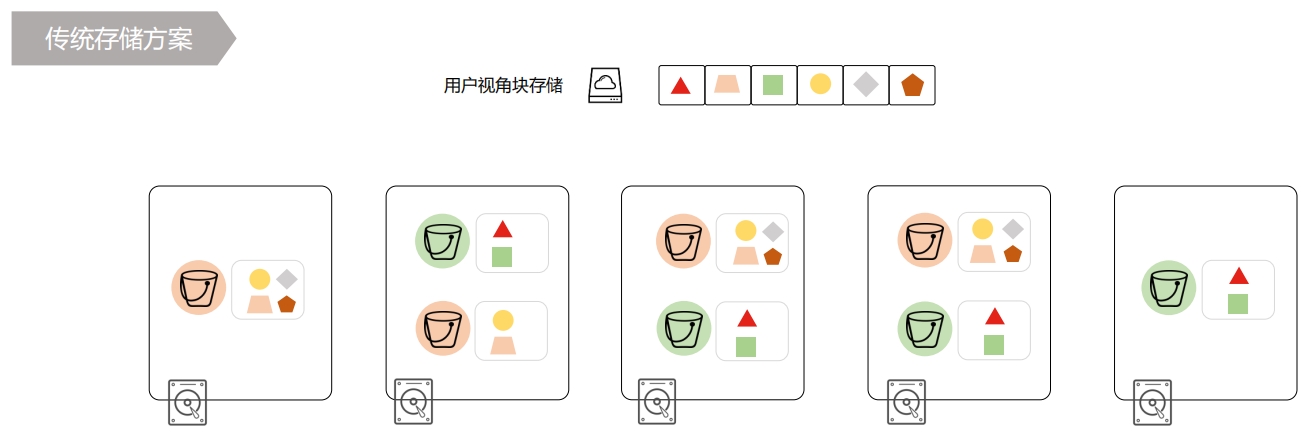

磁盘分配机制 传统存储方案

磁盘分配机制 传统存储方案

使用预分配复制组的方式分配磁盘,集群内增加服务器扩容,必须做数据迁移再平衡,会引发集群抖动,数据以伪随机算法投入复制组内,会造成不同组内数据量不同,磁盘利用率有高有低。

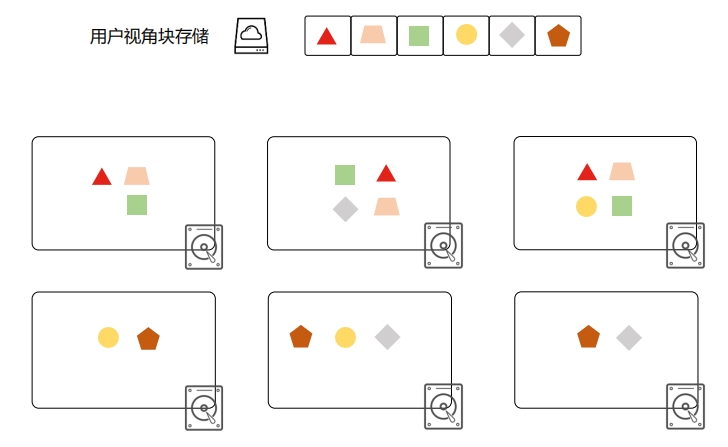

磁盘分配机制 云海存储方案

磁盘分配机制 云海存储方案

根据磁盘负载、磁盘水位、健康状态分配 IO,有均衡的磁盘利用率。集群内增加服务器扩容,新数据直接写到新磁盘上即可,不强制数据迁移再平衡。

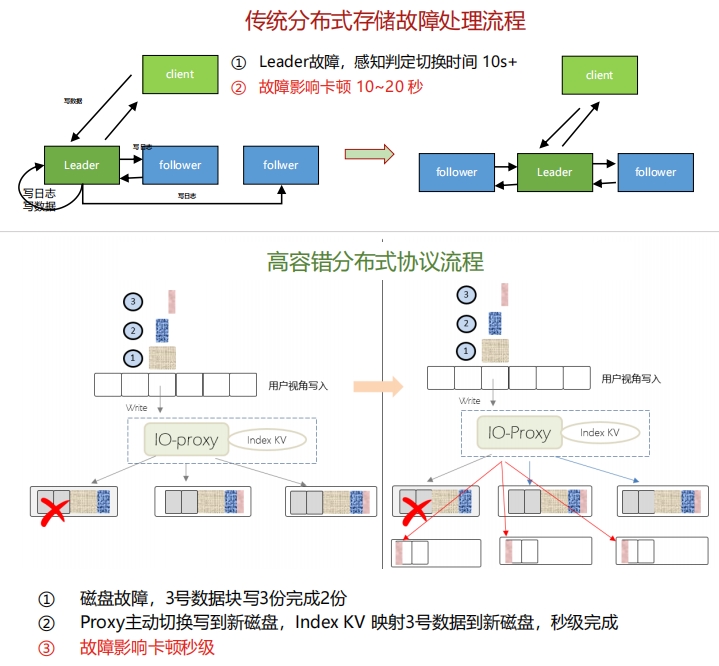

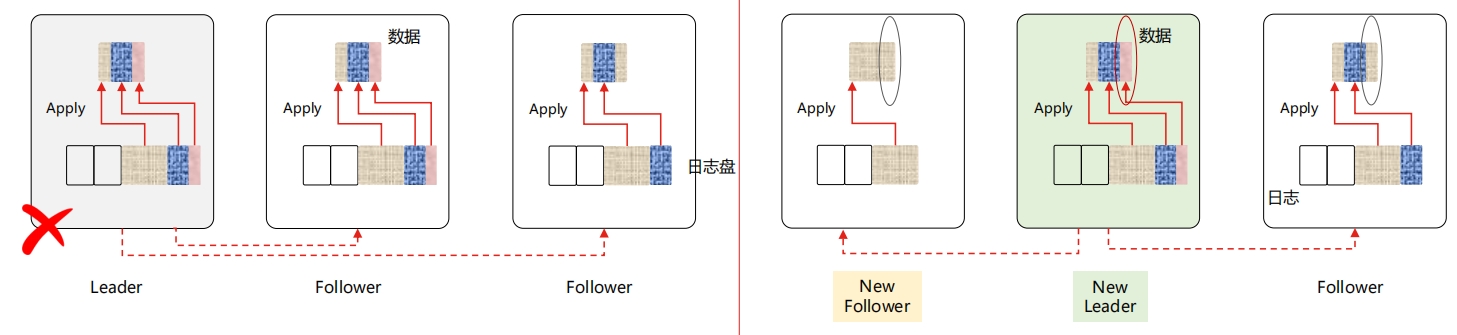

磁盘故障处理

磁盘故障处理

如果是 副本 Leader 发生故障,需要选举新的 Leader,该过程有 10~20 秒左右,敏感业务会受影响。如果原副本 Leader 发生故障,意味着三副本中损失掉一份完整数据,有概率只剩余一份完整数据,丢数据风险。传统存储方案中,日志盘故障等同于整机故障,数据需要全部迁移。增加了故障点,降低了可用性/可靠性。如果2副本同时故障,则数据不可写(写不可用)。

磁盘故障处理

磁盘故障处理

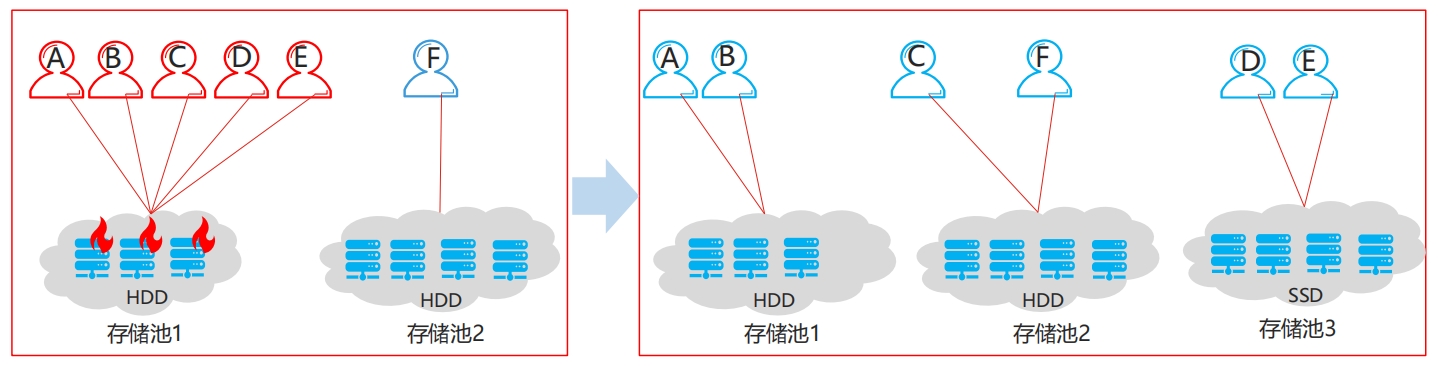

热迁移和热变配

热迁移和热变配

热迁移:如果运行中线上巡检系统监控到局部(业务IO聚集,主副本堆积)过热,通过热迁移手段,无缝将用户迁移到另一个正常资源池上。过程中用户读写基本无感知。热变配:如有必要,可以无缝将用户从低配资源临时迁移到高配资源上。

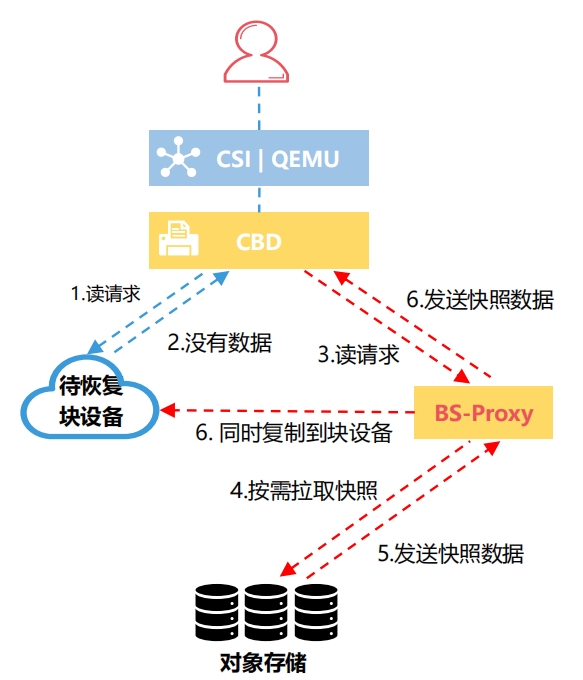

延迟读Lazyread

延迟读Lazyread

可靠性和可用性

可靠性和可用性

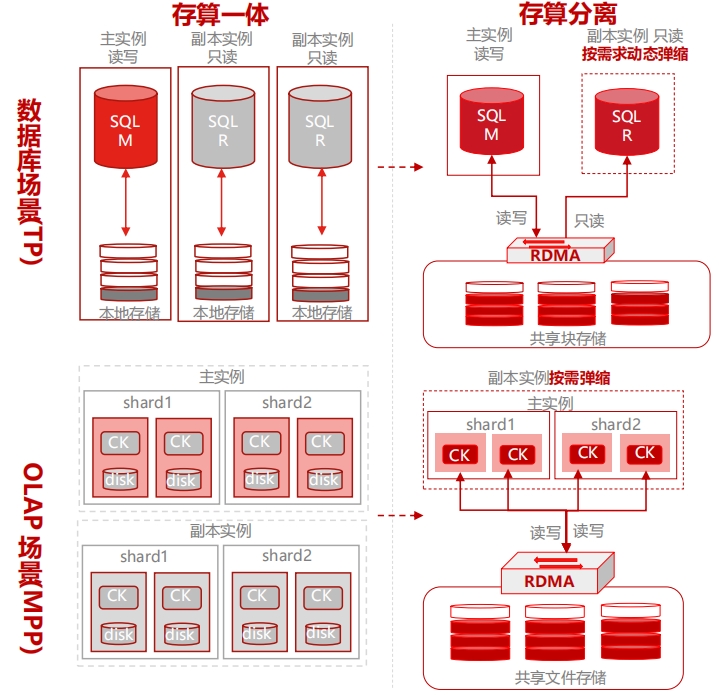

云原生存储的场景实践

云原生存储的场景实践

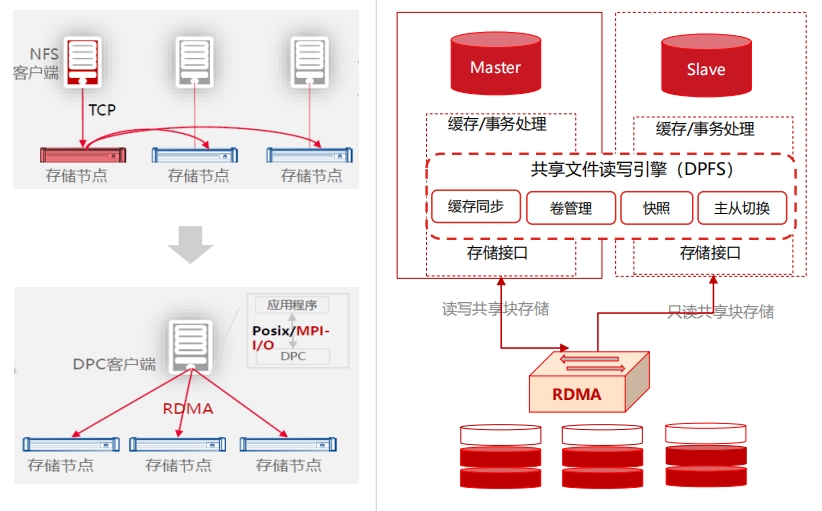

云原生数据库场景实践

云原生数据库场景实践

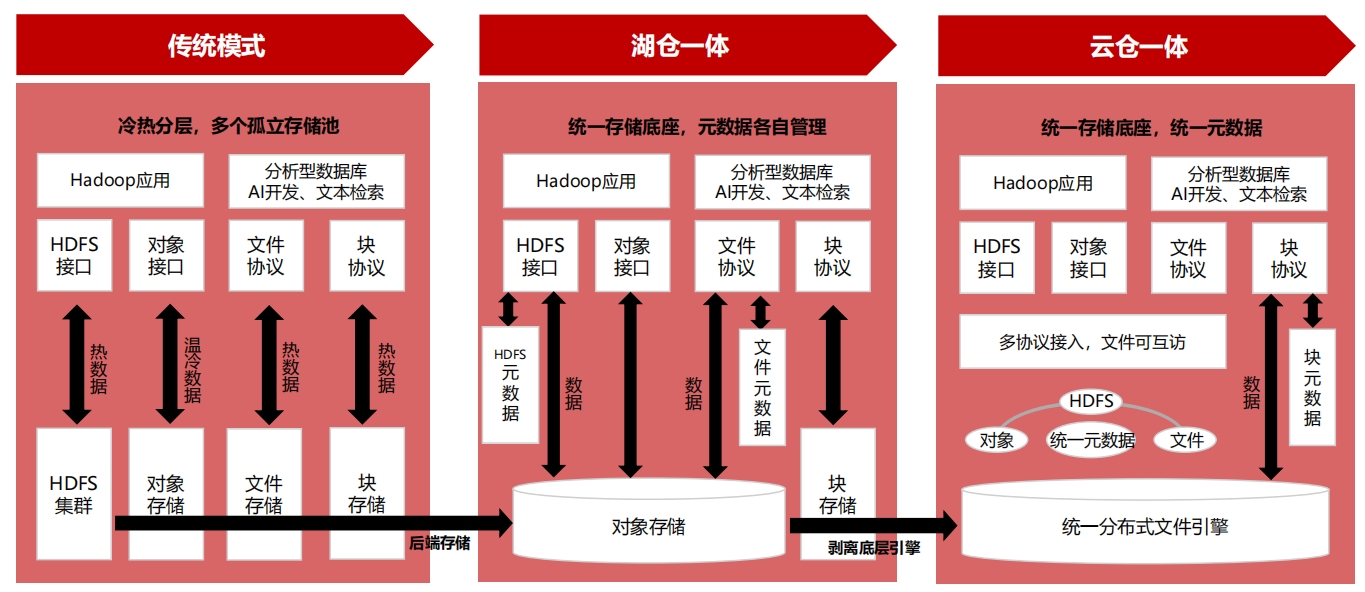

云原生大数据场景实践

云原生大数据场景实践

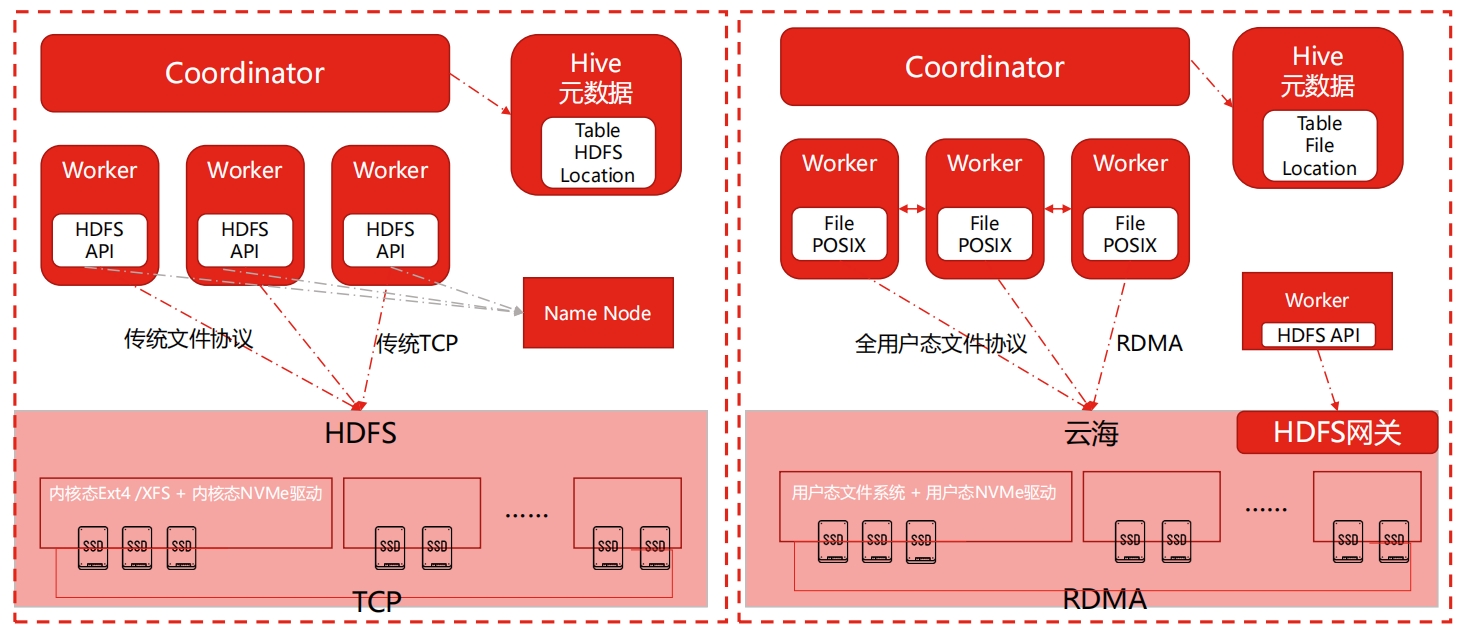

并行文件方案 VS 传统HDFS方案

并行文件方案 VS 传统HDFS方案

并行文件方案优势

并行文件方案优势

有别于传统HDFS方案,并行文件方案通过低延迟RDMA网络、用户态NVMe、SPDK全新存储架构等能力和手段,以满足用户对数据高性能、低成本、高可用的需求。

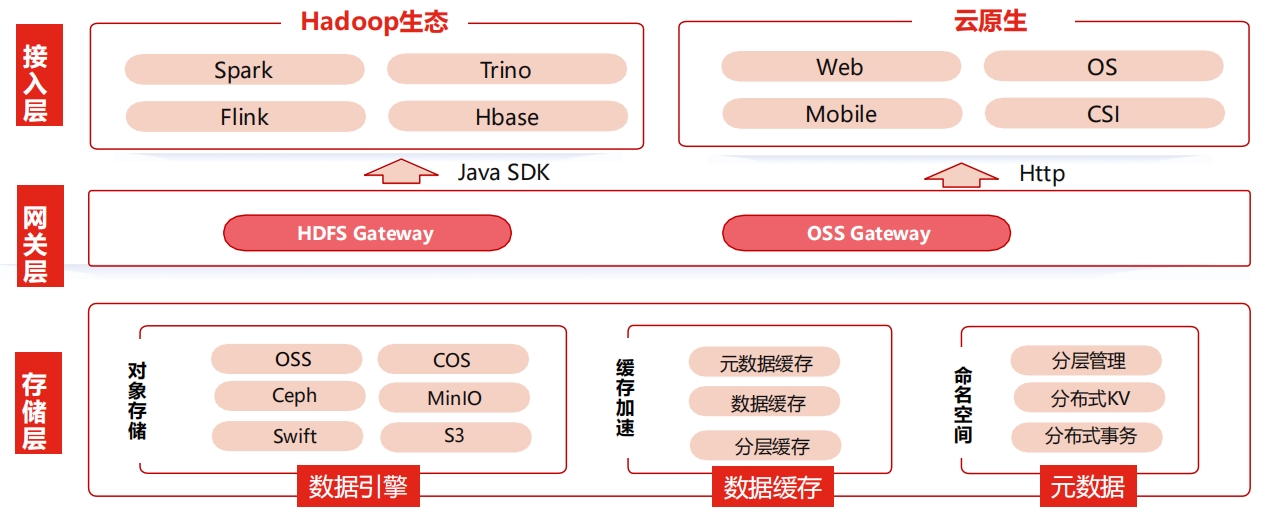

hadoop上云之轻量化方案

hadoop上云之轻量化方案

基于对象存储OSS,为开源大数据生态构建的Hadoop兼容文件系统,提供海量数据的分析和挖掘能力。

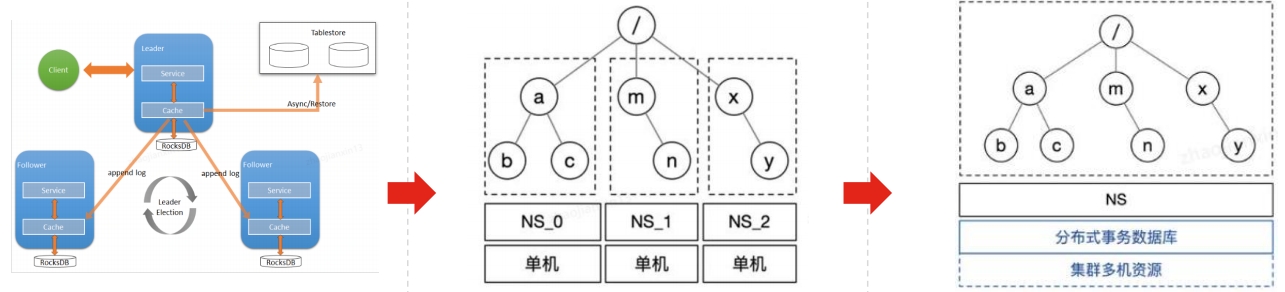

hadoop上云之分层命名空间

hadoop上云之分层命名空间

层级 Namespace 主要是维护文件系统的文件属性、目录树结构等元数据信息,同时支持目录树及文件操作,如:文件 / 目录创建、查找(Lookup/Getattr)删除及重命名(Rename)等。

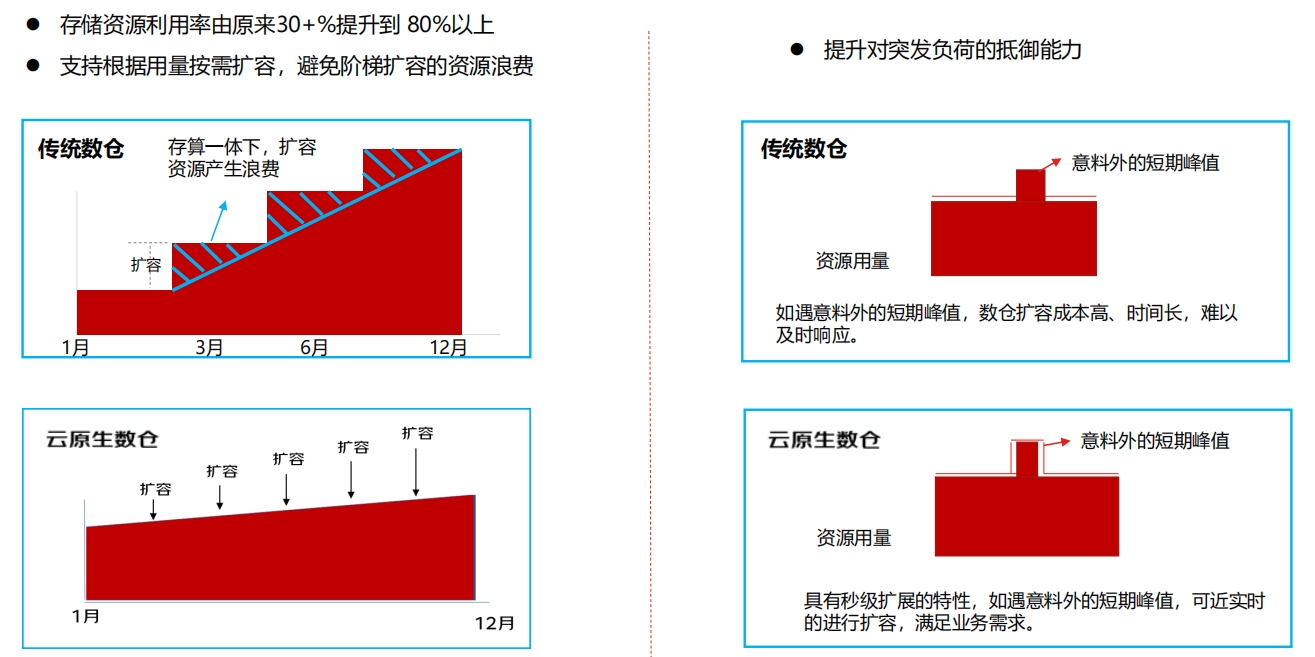

云原生弹性数仓收益

云原生弹性数仓收益

云原生AI训练场景实践

云原生AI训练场景实践

AI训练场景实践

AI训练场景实践

高性能图片、视频存储场景实践

高性能图片、视频存储场景实践

商业化典型案例

商业化典型案例

助力某头部国股行存算分离分析型数据库业务

助力某头部国股行存算分离分析型数据库业务

某头部国股行,是经国务院、中国人民银行批准成立的首批股份制商业银行之一, 近年与国家发展改革委等部门发起“数字化转型伙伴行动”倡议。根据中国人民银行发布《金融科技发展规划》,提出抓住科技浪潮发展新机遇,以人为本全面推进在金融领域深化应用。

助力某保险公司集中式存储升级替代,降本提效

助力某保险公司集中式存储升级替代,降本提效

某保险集团股份有限公司是综合性保险金融集团, 业务范围覆盖财产险、人身险、再保险、资产管理、不动产投资和另类投资、金融科技等领域,为客户提供个性化的保险方案。作为中国保险行业的领先企业,不断推出具有竞争力的产品、加强营销力度、提高服务质量,为客户提供全方位的保障。

助力某券商构建统一云原生存储架构体系

助力某券商构建统一云原生存储架构体系

某券商具有多功能协调发展的金融业务体系。经营范围覆盖:证券经纪;证券投资咨询;与证券交易、证券投资活动有关的财务顾问;证券承销与保荐;证券自营;证券资产管理;融资融券;证券投资基金销售;为期货公司提供中间介绍业务;代销金融产品;证券投资基金托管。

腾讯云国产数据库TDSQL PG版,支持集中式和分布式部署模式;集高扩展性、高SQL兼容度、完整分布式事务支持、高安全能力、多级容灾等能力,适用于GB~PB级的海量HTAP场景。具备高度的Oracle语法兼容能力,配套有完善的迁移评估工具和方案,帮助客户平滑迁移Oracle,。

支持集中式和分布式部署模式

集高扩展性、高SQL兼容度

适用于GB~PB级的海量HTAP场景

具备高度的Oracle语法兼容能力

Zilliz Cloud 为您提供企业版向量数据库引擎,软硬件双重优化,将性能打磨至极致。向量搜索速度是同类产品的 10 倍以上,大幅降低基础设施成本。采用云原生分布式向量数据库架构,可稳定支持百亿规模向量数据。支持水平扩展和垂直扩展,支持多副本,支持性能的线性扩展。

超强性能

高扩展性

高可用性

简单易用

SphereEx DBPlusSuites数据安全合规解决方案支持数据自动采集识别与人工上报离线数据相结合,解决数据不外流条件敏感数据识别。支持多种数据源,包括MySQL、PostgreSQL、 Oracle、SQLServer、openGauss及其他符合上述标准及SQL92规范的数据源。支持多种数据规范的合规性识别,包括GDPR、GB35273等,并支持动态扩展。识别数据风险,给出安全规范及可行实施建议,方便落地。

数据加密存储与计算

数据传输加密

敏感数据识别

离在线数据识别